Новости про NVIDIA и процессоры — МИР NVIDIA

Корпорация NVIDIA начала приглашать на работу инженеров из Transmeta. Это косвенно может указывать на то, что компания заинтересована в создании процессоров, способных исполнять x86-код.

Transmeta была основана в 1995 году и попыталась выйти на рынок центральных процессоров в 2000 году с архитектурой VLIW, однако из-за технологических трудностей и задержек в производстве чипы не пользовались популярностью. Очередные попытки исправить положение не принесли ощутимых результатов, и в 2007 году компания объявила о прекращении производства микросхем и переориентировала свою деятельность на область развития и продажи интеллектуальной собственности, наряду с этим из штата компании было уволено 75 инженеров.

Архитектура VLIW (Very Long Instruction Word) предполагает абстракцию от привязки аппаратной реализации к программным технологиям. Совместимость с процессорными архитектурами прошлых лет реализуется программно, с помощью компилятора кода, таким же путем включается поддержка новых инструкций. VLIW позволяет исполнять параллельно несколько операций через одну инструкцию, задача распределения вычислительных устройств возложена на компилятор. Теоретически, VLIW сильно упрощает архитектуру процессора и снижает его энергопотребление, однако на практике это не вполне удалось подтвердить.

Аналитк Даг Фридмэн высказал мнение агентства Broadpoint AmTech, которое сводится к тому, что NVIDIA может освоить производство x86-процессоров и стать поставщиком таких решений, тем самым сохранив свой бизнес видеокарт и чипсетов, а технология преобразования программного кода позволит ей обойти лицензионные ограничения.

Графические ускорители и центральные процессоры десятилетие назад не имели практически ничего общего, однако значительное развитие архитектуры видеокарт сделало их более программируемыми, позволило выполнять на них задачи общего назначения, одновременно развитие процессоров пошло в направлении увеличения числа ядер, интеграции контроллера памяти и даже графических ядер.

NVIDIA отчётливо осознаёт, что процессоры и видеокарты приближаются друг к другу и в дальнейшем будут объединены. Компания не собирается проигрывать и к тому времени, возможно, выпустит собственные подобные решения. По крайней мере, в этом направлении уже сделаны определённые шаги:

- NVIDIA присоединилась к консорциуму HyperTransport ещё тогда, когда технология была известна под названием Lighting Data Transport, теперь же она используется в качестве системной шины в процессорах AMD.

- Компания участвует в консорциуме по развитию технологии производства чипов Silicon-on-Insulator, применяемой в современных процессорах.

- В январе этого года должность руководителя исследовательских работ занял Уильям Дэлли, известный эксперт в области технологий параллельных вычислений, работавший над процессорами вроде Cell и Larrabee.

- NVIDIA уже производит чипы с архитектурой ARM и продолжает нанимать специалистов в области x86.

- Архитектура Fermi стала более похожей на процессоры, получив кэш-память и поддержку памяти ECC.

Существуют слухи о том, что NVIDIA планирует приобрести VIA Technologies, однако, если это случится, то компания получит только технологии и специалистов, но не лицензию x86, которая не может передаваться третьим лицам. Господин Фридмэн полагает более вероятным, что NVIDIA создаст решения x86 собственной разработки, нежели приобретёт VIA.

Сама же NVIDIA до сих пор отрицает заинтересованность в разработке x86-решений, утверждая, что процессор теперь значит меньше, чем видеокарта.

nvworld.ru

Интегрированный видео процессор|NVIDIA

Hе только компьютерные игры нового поколения требовательны к сегодняшним графическим картам. Пользователям нужно качественное воспроизведение DVD, кодирование/декодирование ТВ сигнала, поддержка высококачественных телевизионных форматов на ПК. Центральный процессор не может справиться с этим в одиночку. Однако новейшие графические процессоры NVIDIA выдерживают интенсивные нагрузки по обработке видео.

Графические процессоры серии NVIDIA GeForce 6 имеют революционный программный видео процессор, обеспечивающий современные высококачественные функции видео. Они обеспечивает ускоренное выполнение многих функций, ранее выполняемых центральным процессором или вторым чипом. Процессор GeForce 6 Series — это два чипа в одном: графический процессор (GPU) и видео процессор.

Видео обработка на GPU включает две основные операции: воспроизведение (декодирование) и запись аналогового видео и конвертирование его в определенный цифровой формат (кодирование). Наиболее распространенный формат кодирования/декодирования — MPEG-2. Другие распространенные форматы, такие как Windows Media Video9 (WMV9), также поддерживаются графическими процессорами GeForce 6 Series.

Видео декодирование

Будучи ключевым элементом современной обработки видео, MPEG-2 является основой для таких функций, как проигрывание DVD. С помощью таких усовершенствованных технологий, как компенсация движения и непрямое косинус-преобразование (IDCT), процессоры GeForce 6 Series очень эффективно справляются с MPEG-2 декодированием, разгружая центральный блок от тяжелых нагрузок при видео проигрывании. В результате мы получаем плавное качественное проигрывание видео и уменьшенное энергопотребление.

Другим важным фактором является то, что процессоры GeForce 6 Series являются полностью программируемыми и поддерживают такие форматы, как WMV9 и MPEG-4. Система компенсации движения NVIDIA обеспечивает ускоренное декодирование различных видео форматов, включая WMV9, MPEG-4, H.264 и DiVX. Благодаря компенсации движения для MPEG-2, подсистема NVIDIA может выполнять большинство интенсивных вычислений, оставляя на долю ЦП сравнительно небольшую нагрузку.

Видео кодирование

Процессоры серии GeForce 6 также обеспечивают ускоренное аппаратное видео кодирование. Видео кодирование является сложным процессом и требует много времени. Процессоры GeForce 6 Series включают систему по оценке движения. Благодаря современным технологиям система оценки движения обеспечивает более высокое качество видео при том же или более низком битрейте, а также более низкие нагрузки на центральный процессор, улучшая общую производительности системы.

Ориентированность на будущее

Видео обработка видео на процессорах GeForce 6 Series была создана с учетом будущих форматов. Гибкость графического процессора позволяет ему с легкостью приспосабливаться к новым и улучшенным видео алгоритмам по мере их появления. Кроме того, функции деинтерлейсинга, гамма-коррекции и уменьшения уровня шума запрограммированы в видео процессор GPU. Благодаря всем этим особенностям и полной программируемости видео процессора серия графических процессоров NVIDIA GeForce 6 создает основу для текущей и будущей поддержки видео устройств и гибких опций просмотра изображения, а также поддерживает широкий спектр сложных видео приложений для удовлетворения потребностей всех потребителей.

www.nvidia.ru

| Процессор | Частота ядра | Частота памяти | Разрядность шины памяти | Частота передачи данных | Пикселей | DirectX |

| GeForce4 MX 420 | 250 МГц | 166 МГц | 128-бит | 2.6 Гб/с | 1 | 7 |

| GeForce4 MX 440 SE | 250 МГц | 333 МГц | 64-бит | 2.6 Гб/с | 1 | 7 |

| GeForce4 MX 440 | 270 МГц | 400 МГц | 128-бит | 6.4 Гб/с | 1 | 7 |

| GeForce 4 MX 440 AGP 8x | 275 МГц | 512 МГц | 128-бит | 8.1 Гб/с | 1 | 7 |

| GeForce 4 MX 460 | 300 МГц | 550 МГц | 128-бит | 8.8 Гб/с | 1 | 7 |

| GeForce MX 4000 | 250 МГц | * | 32-, 64- или 128-бит | * | 1 | 7 |

| GeForce4 Ti 4200 | 250 МГц | 514 МГц (64 МБ) или 444 МГц (128 МБ) | 128-бит | 8.2 Гб/с (64 МБ) или 7.1 Гб/с (128 МБ) | 4 | 8.1 |

| GeForce4 Ti 4200 AGP 8x | 250 МГц | 500 МГц | 128-бит | 8 Гб/с | 4 | 8.1 |

| GeForce4 Ti 4400 | 275 МГц | 550 МГц | 128-бит | 8.8 Гб/с | 4 | 8.1 |

| GeForce4 Ti 4600 | 300 МГц | 650 МГц | 128-бит | 10.4 Гб/с | 4 | 8.1 |

| GeForce4 Ti 4800 SE | 275 МГц | 550 МГц | 128-бит | 8.8 Гб/с | 4 | 8.1 |

| GeForce4 Ti 4800 | 300 МГц | 650 МГц | 128-бит | 10.4 Гб/с | 4 | 8.1 |

| GeForce FX 5200 | 250 МГц | 400 МГц | 64-бит или 128-бит | 3.2 Гб/с или 6.4 Гб/с | 4 | 9.0 |

| GeForce FX 5200 Ultra | 350 МГц | 650 МГц | 128-бит | 10.4 Гб/с | 4 | 9.0 |

| GeForce FX 5600 | 325 МГц | 550 МГц | 128-бит | 8.8 Гб/с | 4 | 9.0 |

| GeForce FX 5500 | 270 МГц | 400 МГц | 64-бит или 128-бит | 3.2 Гб/с или 6.4 Гб/с | 4 | 9.0 |

| GeForce FX 5600 Ultra | 500 МГц | 800 МГц | 128-бит | 12.8 Гб/с | 4 | 9.0 |

| GeForce FX 5700 LE | 250 МГц | 400 МГц | 128-бит | 6.4 Гб/с | 4 | 9.0 |

| GeForce FX 5700 | 425 МГц | 600 МГц | 128-бит | 9,6 Гб/с | 4 | 9.0 |

| GeForce FX 5700 Ultra | 475 МГц | 128-бит | 14.4 Гб/с | 4 | 9.0 | |

| GeForce FX 5800 | 400 МГц | 900 МГц | 128-бит | 14.4 Гб/с | 8 | 9.0 |

| GeForce FX 5800 Ultra | 500 МГц | 1 ГГц | 128-бит | 16 Гб/с | 8 | 9.0 |

| GeForce FX 5900 XT | 390 МГц | 680 МГц | 256-бит | 21.7 Гб/с | 8 | 9.0 |

| GeForce FX 5900 | 400 МГц | 850 МГц | 256-бит | 27.2 Гб/с | 8 | 9.0 |

| GeForce FX 5900 Ultra | 450 МГц | 850 МГц | 256-бит | 27.2 Гб/с | 8 | 9.0 |

| GeForce FX 5950 Ultra | 475 МГц | 950 МГц | 256-бит | 30.4 Гб/с | 8 | 9.0 |

| GeForce PCX 5300 | 325 МГц | 650 МГц | 128-бит | 10.4 Гб/с | 4 | 9.0 |

| GeForce PCX 5750 | 475 МГц | 900 МГц | 128-бит | 14.4 Гб/с | 4 | 9.0 |

| GeForce PCX 5900 | 350 МГц | 500 МГц | 256-бит | 17.6 Гб/с | 8 | 9.0 |

| GeForce PCX 5950 | 475 МГц | 900 МГц | 256-бит | 30.4 Гб/с | 8 | 9.0 |

| GeForce 6200 | 300 МГц | 550 МГц | 128-бит | 8.8 Гб/с | 4 | 9.0c |

| GeForce 6200 LE | 350 МГц | 550 МГц | 64-бит | 4.4 Гб/с | 2 | 9.0c |

| GeForce 6200 (TC) | 350 МГц | 666 МГц * | 32-бит или 64-бит | 2.66 Гб/с или 5.32 Гб/с * | 4 | 9.0c |

| GeForce 6500 (TC) | 400 МГц | 666 МГц * | 32-бит или 64-бит | 2.66 Гб/с или 5.32 Гб/с * | 4 | 9.0c |

| GeForce 6600 | 300 МГц | 550 МГц * | 64-бит или 128-бит | 4.4 Гб/с или 8.8 Гб/с * | 8 | 9.0c |

| GeForce 6600 DDR2 | 350 МГц | 800 МГц * | 128-бит | 8 | 9.0c | |

| GeForce 6600 LE | 300 МГц | * | 64-бит или 128-бит | * | 4 | 9.0c |

| GeForce 6600 GT | 500 МГц | 1 ГГц | 128-бит | 16 Гб/с | 8 | 9.0c |

| GeForce 6600 GT AGP | 500 МГц | 900 МГц | 128-бит | 14.4 Гб/с | 8 | 9.0c |

| GeForce 6800 LE | 300 МГц | 700 МГц | 256-бит | 22.4 Гб/с | 8 | 9.0c |

| GeForce 6800 XT | 325 МГц | 600 МГц | 256 битs | 19.2 Гб/с | 8 | 9.0c |

| GeForce 6800 XT AGP | 325 МГц | 700 МГц | 256 битs | 22.4 Гб/с | 8 | 9.0c |

| GeForce 6800 | 325 МГц | 600 МГц | 256-бит | 19.2 Гб/с | 12 | 9.0c |

| GeForce 6800 AGP | 325 МГц | 700 МГц | 256-бит | 22.4 Гб/с | 12 | 9.0c |

| GeForce 6800 GS | 425 МГц | 1 ГГц | 256-бит | 32 Гб/с | 12 | 9.0c |

| GeForce 6800 GS AGP | 350 МГц | 1 ГГц | 256-бит | 32 Гб/с | 12 | 9.0c |

| GeForce 6800 GT | 350 МГц | 1 ГГц | 256-бит | 32 Гб/с | 16 | 9.0c |

| GeForce 6800 Ultra | 400 МГц | 1.1 ГГц | 256-бит | 35.2 Гб/с | 16 | 9.0c |

| GeForce 6800 Ultra Extreme | 450 МГц | 1.1 ГГц | 256-бит | 35.2 Гб/с | 16 | 9.0c |

| GeForce 7100 GS (TC) | 350 МГц | 666 МГц * | 64-бит | 5.3 Гб/с * | 4 | 9.0c |

| GeForce 7200 GS (TC) | 450 МГц | 800 МГц * | 64-бит | 6.4 Гб/с * | 4 | 9.0c |

| GeForce 7300 SE (TC) | 225 МГц | * | 64-бит | * | 4 | 9.0c |

| GeForce 7300 LE (TC) | 450 МГц | 648 МГц * | 64-бит | 5.2 Гб/с * | 4 | 9.0c |

| GeForce 7300 GS (TC) | 550 МГц | 810 МГц * | 64-бит | 6.5 Гб/с * | 4 | 9.0c |

| GeForce 7300 GT (TC) | 350 МГц | 667 МГц | 128-бит | 10.6 Гб/с | 8 | 9.0c |

| GeForce 7600 GS | 400 МГц | 800 МГц | 128-бит | 12.8 Гб/с | 12 | 9.0c |

| GeForce 7600 GT | 560 МГц | 1.4 ГГц | 128-бит | 22.4 Гб/с | 12 | 9.0c |

| GeForce 7800 GS | 375 МГц | 1.2 ГГц | 256-бит | 38.4 Гб/с | 16 | 9.0c |

| GeForce 7800 GT | 400 МГц | 1 ГГц | 256-бит | 32 Гб/с | 20 | 9.0c |

| GeForce 7800 GTX | 430 МГц | 1.2 ГГц | 256-бит | 38.4 Гб/с | 24 | 9.0c |

| GeForce 7800 GTX 512 | 550 МГц | 1.7 ГГц | 256-бит | 54.4 Гб/с | 24 | 9.0c |

| GeForce 7900 GS | 450 МГц | 1.32 ГГц | 256-бит | 42.2 Гб/с | 20 | 9.0c |

| GeForce 7900 GT | 450 МГц | 1.32 ГГц | 256-бит | 42.2 Гб/с | 24 | 9.0c |

| GeForce 7900 GTX | 650 МГц | 1.6 ГГц | 256-бит | 51.2 Гб/с | 24 | 9.0c |

| GeForce 7950 GT | 550 МГц | 1.4 ГГц | 256-бит | 44.8 Гб/с | 24 | 9.0c |

| GeForce 7950 GX2 ** | 500 МГц | 1.2 ГГц | 256-бит | 38.4 Гб/с | 24 | 9.0c |

| GeForce 8400 GS *** | 450 / 900 МГц | 800 МГц | 64-бит | 6.4 Гб/с | 16 | 10 |

| GeForce 8500 GT *** | 450 / 900 МГц | 666 МГц или 800 МГц | 128-бит | 10.6 Гб/с или 12.8 Гб/с | 16 | 10 |

| GeForce 8600 GT DDR2 *** | 540 / 1.18 ГГц | 666 МГц или 800 МГц | 128-бит | 10.6 Гб/с или 12.8 Гб/с | 32 | 10 |

| GeForce 8600 GT GDDR3 *** | 540 / 1.18 ГГц | 1.4 ГГц | 128-бит | 22.4 Гб/с | 32 | 10 |

| GeForce 8600 GTS *** | 675 / 1.45 ГГц | 2 ГГц | 128-бит | 32 Гб/с | 32 | 10 |

| GeForce 8800 GS *** ^ | 550 / 1,375 МГц | 1.6 ГГц | 192-бит | 38.4 Гб/с | 96 | 10 |

| GeForce 8800 GT *** ^ | 600 / 1.5 ГГц | 1.8 ГГц | 256-бит | 57.6 Гб/с | 112 | 10 |

| GeForce 8800 GTS *** | 500 / 1.2 ГГц | 1.6 ГГц | 320-бит | 64 Гб/с | 96 | 10 |

| GeForce 8800 GTS 512 *** ^ | 650 / 1,625 МГц | 1.94 ГГц | 256-бит | 62.08 Гб/с | 128 | 10 |

| GeForce 8800 GTX *** | 575 / 1.35 ГГц | 1.8 ГГц | 384-бит | 86.4 Гб/с | 128 | 10 |

| GeForce 8800 Ultra *** | 612 / 1.5 ГГц | 2.16 ГГц | 384-бит | 103.6 Гб/с | 128 | 10 |

| GeForce 9400 GT *** ^ | 550 / 1.4 ГГц | 800 МГц | 128-бит | 12.8 Гб/с | 16 | 10 |

| GeForce 9500 GT *** ^ | 550 / 1.4 ГГц | 1 ГГц (DDR2) или 1.6 ГГц (GDDR3) | 128-бит | 16 Гб/с (DDR2) или 25.6 Гб/с (GDDR3) | 32 | 10 |

| GeForce 9600 GSO *** ^ | 550 / 1.35 ГГц | 1.6 ГГц | 192-бит | 38.4 Гб/с | 96 | 10 |

| GeForce 9600 GSO 512 *** ^ | 650 / 1,625 МГц | 1.8 ГГц | 256-бит | 57.6 Гб/с | 48 | 10 |

| GeForce 9600 GT *** ^ | 600 / 1.5 ГГц или 650 / 1,625 МГц | 1.8 ГГц | 256-бит | 57.6 Гб/с | 64 | 10 |

| GeForce 9800 GT *** ^ | 600 / 1,500 ГГц | 1.8 ГГц | 256-бит | 57.6 Гб/с | 112 | 10 |

| GeForce 9800 GTX *** ^ | 675 / 1,688 МГц | 2.2 ГГц | 256-бит | 70.4 Гб/с | 128 | 10 |

| GeForce 9800 GTX+ *** ^ | 738 / 1,836 МГц | 2.2 ГГц | 256-бит | 70.4 Гб/с | 128 | 10 |

| GeForce 9800 GX2 ** *** ^ | 600 / 1.5 ГГц | 2 ГГц | 256-бит | 64 Гб/с | 128 | 10 |

| GeForce G 100 *** ^ | 567 / 1.4 ГГц | 1 ГГц | 64-бит | 8 Гб/с | 8 | 10 |

| GeForce GT 120 *** ^ | 500 / 1.4 ГГц | 1 ГГц | 128-бит | 16 Гб/с | 32 | 10 |

| GeForce GT 130 *** ^ | 500 / 1.25 ГГц | 1 ГГц | 192-бит | 24 Гб/с | 48 | 10 |

| GeForce GTS 150 *** ^ | 738 / 1,836 МГц | 2 ГГц | 256-бит | 64 Гб/с | 128 | 10 |

| GeForce 205 *** ^ | 589 / 1,402 МГц | 1 ГГц | 64-бит | 8 Гб/с | 8 | 10.1 |

| GeForce 210 *** ^ | 589 / 1,402 МГц | 1 ГГц | 64-бит | 8 Гб/с | 16 | 10.1 |

| GeForce GT 220 *** ^ | 625 / 1,360 МГц | 1.58 ГГц | 128-бит | 25.28 Гб/с | 48 | 10.1 |

| GeForce GT 240 *** ^ | 550 / 1,340 МГц | 1.8 ГГц (DDR3) или 2 ГГц (GDDR3) или 3.4 ГГц (GDDR5) | 128-бит | 28.8 Гб/с (DDR3) или 32 Гб/с (GDDR3) или 54.4 Гб/с (GDDR5) | 96 | 10.1 |

| GeForce GTS 240 *** ^ | 675 / 1,620 МГц | 2.2 ГГц | 256-бит | 70.4 Гб/с | 112 | 10 |

| GeForce GTS 250 512 МБ *** ^ | 675 / 1,620 МГц | 2 ГГц | 256-бит | 64 Гб/с | 128 | 10 |

| GeForce GTS 250 1 GB *** ^ | 738 / 1,836 МГц | 2.2 ГГц | 256-бит | 70.4 Гб/с | 128 | 10 |

| GeForce GTX 260 *** ^ | 576 / 1,242 МГц | 2 ГГц | 448-бит | 112 Гб/с | 192 | 10 |

| GeForce GTX 260/216 *** ^ | 576 / 1,242 МГц | 2 ГГц | 448-бит | 112 Гб/с | 216 | 10 |

| GeForce GTX 275 *** ^ | 633 / 1,404 МГц | 2.268 ГГц | 448-бит | 127 Гб/с | 240 | 10 |

| GeForce GTX 280 *** ^ | 602 / 1,296 МГц | 2.21 ГГц | 512-бит | 141.7 Гб/с | 240 | 10 |

| GeForce GTX 285 *** ^ | 648 / 1,476 МГц | 2.48 ГГц | 512-бит | 159 Гб/с | 240 | 10 |

| GeForce GTX 295 ** *** ^ | 576 / 1,242 МГц | 2 ГГц | 448-бит | 112 Гб/с | 240 | 10 |

| GeForce 310 *** ^ | 589 / 1,402 МГц | 1 ГГц | 64-бит | 8 Гб/с | 16 | 10.1 |

| GeForce 315 *** ^ | 475 / 1,100 МГц | 1.58 ГГц | 64-бит | 12.6 Гб/с | 48 | 10.1 |

| GeForce GT 320 *** ^ | 540 / 1,302 МГц | 1.58 ГГц | 128-бит | 25.3 Гб/с | 72 | 10.1 |

| GeForce GT 330 *** ^ | 500 / 1,250 МГц или 550 / 1,340 МГц | 1 ГГц или 1.6 ГГц | 128-бит, 192-бит, или 256-бит | (depends on config) | 96 или 112 | 10 |

| GeForce GT 340 *** ^ | 550 / 1,340 МГц | 3.4 ГГц | 128-бит | 54.4 Гб/с | 96 | 10.1 |

| GeForce GT 420 *** ^ | 700 / 1,400 МГц | 1.8 ГГц | 128-бит | 28.8 Гб/с | 48 | 11 |

| GeForce GT 430 *** ^ | 700 / 1,400 МГц | 1.8 ГГц | 128-бит | 28.8 Гб/с | 96 | 11 |

| GeForce GT 440 *** ^ | 594 / 1,189 МГц | 1.6 (1.5 GB) или 1.8 ГГц (3 GB) | 192-бит | 38.4 (1.5 GB) или 43.2 Гб/с (3 GB) | 144 | 11 |

| GeForce GTS 450 *** ^ | 783 / 1,566 МГц | 3.6 ГГц | 128-бит | 57.7 Гб/с | 192 | 11 |

| GeForce GTX 460 SE *** ^ | 650 / 1,300 МГц | 3.4 ГГц | 256-бит | 108.8 Гб/с | 288 | 11 |

| GeForce GTX 460 *** ^ | 675 / 1,350 МГц | 3.6 ГГц | 192-бит (768 МБ) или 256-бит (1 GB) | 86.4 Гб/с (768 МБ) или 115.2 Гб/с (1 GB) | 336 | 11 |

| GeForce GTX 465 *** ^ | 607 / 1,215 МГц | 3,206 МГц | 256-бит | 102.6 Гб/с | 352 | 11 |

| GeForce GTX 470 *** ^ | 607 / 1,215 МГц | 3,348 МГц | 320-бит | 133.9 Гб/с | 448 | 11 |

| GeForce GTX 480 *** ^ | 700 / 1,401 МГц | 3,696 МГц | 384-бит | 177.4 Гб/с | 480 | 11 |

| GeForce GTX 560 Ti *** ^ | 822 / 1,644 МГц | 4,008 МГц | 256-бит | 128.3 Гб/с | 384 | 11 |

| GeForce GTX 570 *** ^ | 732 / 1,464 МГц | 3.8 ГГц | 320-бит | 152 Гб/с | 480 | 11 |

| GeForce GTX 580 *** ^ | 772 / 1,544 МГц | 4,008 МГц | 384-бит | 192.4 Гб/с | 512 | 11 |

| GeForce GTX 580 | 607 / 1,215 МГц x2 | 3,414 МГц x2 | 3 |

hardwareguide.ru

Возможности и преимущества|NVIDIA

Унифицированная архитектура NVIDIA®:

Полностью унифицированное шейдерное ядро ядро динамически распределяет ресурсы для выполнения операций с геометрией, вершинами, физикой и пикселями, обеспечивая невероятную игровую производительность — вдвое выше, чем у предыдущего поколения GPU.

Полноценная поддержка Microsoft® DirectX® 10:

Первый в мире DirectX 10 GPU с полной поддержкой Shader Model 4.0 обеспечивает несравненные уровни графической реалистичности и эффектов кинематографического качества.

Технология NVIDIA® SLI1:

Повышает производительность до 100% по сравнению с одиночной видеокартой, гарантируя несравненные игровые возможности благодаря совместной работе двух видеокарт. Будучи ключевым элементом в обеспечении производительной графики PCI Express®, SLI поднимает производительность в современных играх до невероятных вершин.

Поддержка PCI Express 2.0:

Создан для работы с новой шиной PCI Express 2.0, обеспечивая гладкий переход на новые, ресурсозависимые игры и 3D приложения путем увеличения полосы пропускания PCI Express 2.0 до 5 GT/s (вдвое больше по сравнению с первым поколением PCI Express). Продукты PCI Express 2.0 полностью обратно совместимы с существующими материнскими платами PCI Express.

Технология GigaThread™:

Многопоточная архитектура поддерживает тысячи независимых одновременных потоков, обеспечивая экстремальную эффективность работы передовых шейдерных блоков нового поколения.

Подсистема NVIDIA® Lumenex™:

Обеспечивает потрясающее качество изображения и точность благодаря операциям с плавающей точкой при высочайшей скорости смены кадров:

Сглаживание 16X:

Молниеносное высококачественное сглаживание на скоростях до 16x полностью устраняет ступенчатость краев.

128-bit освещение в широком динамическом диапазоне (HDR) на базе операций с плавающей точкой:

Вдвое выше точность по сравнению с предыдущими поколениями для получения необычайно реалистичных световых эффектов – теперь с поддержкой сглаживания.

Технология NVIDIA® Quantum Effects™:

Передовые шейдеры, созданные для физических расчетов, обеспечивают новый уровень физических эффектов, эмулируемых и отрисовываемых с помощью GPU – одновременно освобождая CPU для игрового процесса и AI.

Унифицированная драйверная архитектура NVIDIA® ForceWare (UDA):

Передовой уровень совместимости, надежности и стабильности с поддержкой широкого спектра игр и приложений. ForceWare обеспечивает наилучшие возможности сразу после установки видеокарты для всех пользователей, а также регулярное обновление возможностей и повышение производительности в течение срока службы графических процессоров NVIDIA GeForce®.

Оптимизации и поддержка OpenGL® 2.0:

гарантирует превосходную совместимость и производительность для приложений OpenGL.

Два 400MHz RAMDAC:

Высокоскоростные RAMDAC поддерживают два QXGA монитора с ультравысокой частотой обновления – до 2048×1536@85Hz.

Два двухканальных DVI:

Поддержка самых больших панелей высочайших разрешений до 2560×1600 с поддержкой скоростного цифрового контента (HDCP).

Технология NVIDIA® PureVideo™ HD2:

Ускорение декодирования видео высокой четкости вместе с пост-обработкой обеспечивает беспрецедентную четкость картинки, плавность видео, точность цветов и аккуратное масштабирование изображения в фильмах и видео.

Дискретный программируемый видео процессор:

NVIDIA PureVideo – это дискретное программируемое ядро в графических процессорах NVIDIA, которое обеспечивает превосходное качество картинки и ультра-плавное воспроизведение видео при минимальной нагрузке на CPU и потреблении энергии.

Аппаратное ускорение декодирования:

Ультра-плавное воспроизведение H.264, VC-1, WMV и MPEG-2 фильмов высокой и стандартной четкости.

Поддержка HDCP3:

отвечает требованиям по управлению защитой выходов (HDCP) и по безопасности для форматов Blu-ray и HD DVD, позволяя воспроизводить зашифрованный контент на ПК при подключении к HDCP совместимым мониторам. Требуются другие HDCP-совместимые компоненты

Передовой пространственно-временной деинтерлейсинг:

повышает четкость чересстрочного контента высокой и стандартной четкости на экранах с прогрессивной разверткой и передает четкие и яркие картинки, не уступающие домашним кинотеатрам.

Высококачественное масштабирование:

увеличивает размер фильмов низкого разрешения до разрешений HDTV, сохраняя четкость и ясность картинки. Также уменьшает размер окна видео, включая видео высокой четкости, поддерживая высокий уровень детализации изображения.

Обратный пересчет кадров (коррекция пересчета 3:2 & 2:2):

Восстанавливает оригинальный киноформат из видео, полученного конвертацией из фильма (DVD, 1080i HD контент), обеспечивая более точное воспроизведение фильмов и качество картинки.

Коррекция пересчета:

В случае редактирования видео после конвертации с 24 в 25 или 30 кадров, поправки могут исказить шаг 3:2 или 2:2. PureVideo использует передовые техники определения неправильных правок, восстановления оригинального контента и передачи отличной детализации кадр за кадром для получения плавного и привлекательного видео изображения.

Снижение уровня шума:

Улучшает качество кино изображения путем устранения нежелательных артефактов.

Улучшение качества краев:

Повышение резкости изображения в фильмах путем повышения контраста линий и объектов.

Интегрированный SD и HD TV выход:

Функциональность мирового класса ТВ выхода через разъемы Composite, S-Video, Component или DVI. Поддержка разрешений до 1080i/1080p в зависимости от типа соединения и возможностей ТВ.

1 — Только для NVIDIA SLI сертифицированных версий GeForce PCI Express GPU.

2 — Требуется поддерживаемое видео ПО. Возможности зависят от продукта.

3 – Требуются другие HDCP-совместимые компоненты.

www.nvidia.ru

Новости про NVIDIA и гибридные процессоры — МИР NVIDIA

Долгое время многие обозреватели удивлялись, почему Samsung, Qualcomm и Texas Instruments с лёгкостью заставляют свои двухъядерные процессоры, изготовленные по нормам 40/45 нм, работать на частоте более 1,0 ГГц, в то время как NVIDIA застряла на этой цифре со своими процессорами Tegra 2.

Однако несколько дней назад, компании LG и NVIDIA анонсировали первое мобильное устройство, построенное на чипе Tegra 2 с частотой 1,2 ГГц. Этот смартфон в форм-факторе слайдер получил название LG Optimus note.

Кроме процессора Tegra 2 смартфон может похвастаться выдвижной QWERTY клавиатурой, дисплеем WVGA NOVA с диагональю 4”. Также гаджет оснащён 5 Мпикс тыльной камерой со светодиодной вспышкой, фронтальной VGA камерой, 8 ГБ встроенной памяти и традиционными средствами коммуникации. В качестве ОС на смартфон предустановленна Android 2.3 Gingerbread.

Наши коллеги с сайта Fudzilla связались с представителями NVIDIA, которые уверили журналистов в том, что выпущенный смартфон будет не единственным устройством с процессором Tegra 2 работающим на частоте 1,2 ГГц. Безусловно, куда больше внимания сейчас уделяется процессорам Tegra 3, телефоны на базе которых должны появится в продаже в начале следующего года.

Похоже, что в будущем мы станем свидетелями того, как одни и те же чипы компании будут увеличивать свою тактовую частоту, благодаря оптимизациям при их производстве.

В данном случае мы видим прирост частоты в 20%, однако до сих пор неизвестно, насколько при этом увеличилось тепловыделение и энергопотребление процессора. К сожалению, никто в NVIDIA не захотел это комментировать, сказав лишь, что изменения незначительны.

nvworld.ru

Новости про графические процессоры — МИР NVIDIA

Компания CyberPower Inc. объявила о презентации Zeus Hercules, нового игрового ноутбука оснащённого системой охлаждения Intel Hyperbaric и графической системой Iris Pro 5200, которая является самым быстрым решением Intel в плане графики.

Цена за данную модель ноутбука стартует от 1039 долларов США. Эта модель содержит 14” экран разрешением 1920х1080 пикс. при толщине дисплея всего 3,2 мм. Ноутбук работает с процессором Intel Core i7-4750HQ с максимальной частотой в 3,2 ГГц и графическим ядром Iris Pro 5200, встроенным в центральный процессор. Этот GPU имеет динамическую частоту, поддерживает DirectX 11 и применяет технологию динамической видеопамяти, позволяющей использовать на нужды графики до 1,7 ГБ. Хотя графические процессоры Intel в последнее время делают большие успехи в плане производительности, им по-прежнему далеко до интегрируемых решений AMD и тем более до дискретных видеокарт, так что использование в игровом ноутбуке графики Intel выглядит весьма странным.

Базовая конфигурация лэптопа включает 8 ГБ ОЗУ (расширяемых до 16 ГБ), винчестер на 1 ТБ со скоростью вращения 5400 об/мин, кардридер 6-в-1, Gigabit Ethernet, Wi-Fi b/g/n и Bluetooth 4.0+ LE. Также над экраном расположена веб-камера разрешением 1 Мпикс. Кроме этого ноутбук оснащён клавиатурой, размер с лист А4, и трекпадом с распознаванием жестов и полосой прокрутки, что, в общем-то, является рядовой функцией.

Из устройств ввод-вывода можно отметить аудио выход и микрофонный вход, порты USB 3.0, mini DisplayPort и выход HDMI. За дополнительные деньги ноутбук можно оснастить внешней звуковой картой Creative Labs Sound Blaster X-Fi Go! Pro и USB усилителем Enermax Dreambass Genie, а возможности беспроводных подключений можно улучшить установкой решений Intel Centrino и Killer Wireless-N.

По заверениям разработчиков, при толщине всего 2 см, лэптоп Hercules на 18% тоньше любого другого игрового ноутбука и на 12% легче. Вот только игровым его можно назвать с натяжкой.

nvworld.ru

Графический процессор — Википедия

Эта страница требует существенной переработки. Возможно, её необходимо викифицировать, дополнить или переписать.Пояснение причин и обсуждение — на странице Википедия:К улучшению/20 мая 2018. |

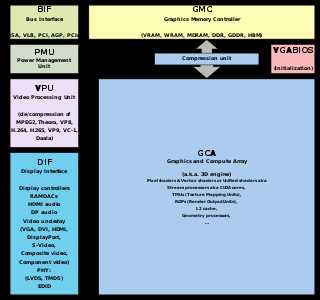

Блок-схема графического процессора

Блок-схема графического процессораГрафический процессор (англ. graphics processing unit, GPU) — отдельное устройство персонального компьютера или игровой приставки, выполняющее графический рендеринг; в начале 2000-х годов графические процессоры стали массово применяться и в других устройствах: планшетные компьютеры, встраиваемые системы, цифровые телевизоры.

Современные графические процессоры очень эффективно обрабатывают и отображают компьютерную графику, благодаря специализированной конвейерной архитектуре они намного эффективнее в обработке графической информации, чем типичный центральный процессор.

Графический процессор в современных видеокартах (видеоадаптерах) применяется в качестве ускорителя трёхмерной графики.

Может применяться как в составе дискретной видеокарты, так и в интегрированных решениях (встроенных в северный мост либо в гибридный процессор).

Содержание

- 1 Описание

- 2 Внешний графический процессор (eGPU)

- 3 История

- 4 Программное обеспечение

- 5 См. также

- 6 Примечания

- 7 Ссылки

Описание

ru.wikipedia.org