Что такое нейросеть. Объясняем простыми словами — Секрет фирмы

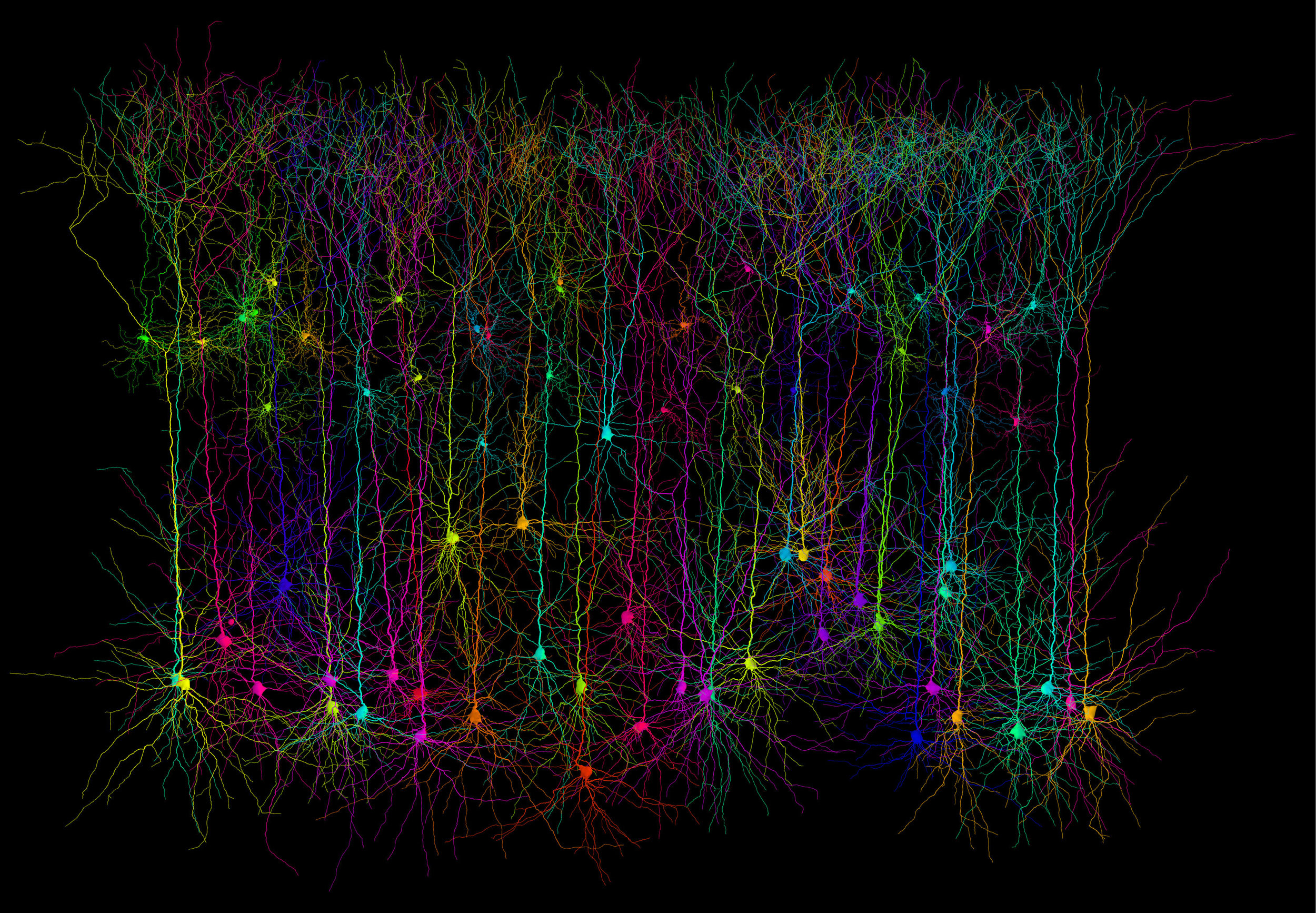

Человеческий мозг состоит из нейронов, связанных между собой синапсами и передающих электрохимические импульсы. Нейросеть же состоит из искусственных нейронов — вычислительных элементов, созданных по модели биологического нейрона.

Нейронные сети уже широко используются в разных областях жизни — распознают лица (в том числе ловят преступников), диагностируют болезни, работают как голосовые помощники. В том числе растёт их применение в бизнесе: оценка эффективности сотрудников, одобрение кредита, чат-боты, управление кол-центрами.

Примеры употребления на «Секрете»

«То, что мы уже начали повсеместно использовать нейронные сети, но ещё не поняли до конца, как они работают, — это очень странный и очень интересный факт».

(CEO Wallarm Иван Новиков — об угрозах искусственного интеллекта.)

«Главное отличие нейронных сетей от других технологий в том, что они требуют минимальной работы с признаками (feature engineering). Если при классическом машинном обучении чаще всего приходится производить сложные алгоритмические процедуры с исходными обучающими данными, то нейронные сети удаётся хорошо обучать на сырых данных».

Если при классическом машинном обучении чаще всего приходится производить сложные алгоритмические процедуры с исходными обучающими данными, то нейронные сети удаётся хорошо обучать на сырых данных».

(Руководитель группы исследования технологий извлечения информации ABBYY Анатолий Старостин — о том, что нужно знать про нейросети.)

Нюансы

Искусственная нейросеть, конечно, всё ещё значительно отличается от человеческого мозга. Для работы даже миллиона искусственных нейронов требуются мощные компьютеры. Синапсов, или связей между нейронами, в биологическом мозге тоже намного больше, и работать они могут параллельно друг с другом, в отличие от компьютера, который даже простую задачу разбивает на последовательные шаги.

Интересные факты

Нейросети уже научились делать множество вещей: сочинять песни, прогнозировать урожай, распознавать сексуальное влечение, диагностировать депрессию, писать хорроры, бороться с коррупцией и подделывать голоса.

Статью проверил:

Нейросеть 2021

Камера с искусственным интеллектом

Современный процессор должен иметь возможность запускать нейросетевую видеоаналитику. В сравнении с обычными процессоры умных камер чаще всего имеют улучшенный графический (GPU, Graphics Processing Unit) чипсет, который дает больше вычислительной мощности для алгоритмов, потребляя при этом меньше энергии и выделяя меньше тепла.

В сравнении с обычными процессоры умных камер чаще всего имеют улучшенный графический (GPU, Graphics Processing Unit) чипсет, который дает больше вычислительной мощности для алгоритмов, потребляя при этом меньше энергии и выделяя меньше тепла.

Стоит отметить, что со стремительным развитием искусственного интеллекта начинают появляться специализированные чипсеты, приходящие на смену привычным CPU (Central Processing Unit) и GPU. Среди них NPU (Neral Processing Unit) или TPU (Tensor Processing Unit). Расчетные мощности нейросетей требуют от процессоров значительных ресурсов. До сегодняшнего времени пользователи выбирали, на каком типе процессоров производить расчеты, графическом (GPU) или центральном (CPU). При этом GPU более подходит под требования нейросетевых вычислений, а значит выполняет их более эффективно. В настоящее время производители процессоров, комбинируя преимущества CPU и GPU в одной микросхеме, выпускают специализированные гибридные чипы, узко направленные на нейросетевые вычисления или работу с «морем» множителей, потребляющие при этом меньше энергии.

Как различать камеры с искусственным интеллектом? Читайте в статье «Как устроены камеры с искусственным интеллектом» >>>

Что умеет нейросетевая видеоаналитика?

Часто приходится слышать, что рынок систем видеонаблюдения все больше коммодитизируется. Множество продуктов со схожей функциональностью (или, по крайней мере, схожими обещаниями производителя) затрудняют выбор для пользователя, и одним из главных аргументов становится имя вендора и его репутация. У самих производителей остается два пути: или ввязаться в ценовую войну, делая ставку на максимальную оптимизацию затрат, или предложить что-то действительно новое и прорывное.

Тренд, который пытаются оседлать разработчики, выбравшие второй путь, – искусственный интеллект, основанный на нейронных сетях и глубоком обучении. Зародившийся несколько лет назад рынок ИИ-видеоаналитики находится в стадии взрывного роста. Новая технологическая волна добавила оптимизма небольшим, но амбициозным компаниям. Кажется, у них появился шанс прорваться к лидерству – в перспективе нескольких лет.

Новая технологическая волна добавила оптимизма небольшим, но амбициозным компаниям. Кажется, у них появился шанс прорваться к лидерству – в перспективе нескольких лет.

Однако хайп, поднятый новым модным трендом, вызывает здравые опасения умудренных опытом профессионалов рынка безопасности, как со стороны клиента, который ищет решение для своих задач, так и со стороны интегратора, который строит стратегию долгосрочного развития. Это очень похоже на очередной технологический «пузырь». Такой, который уже успел надуться вокруг видеоаналитики без нейронных сетей и громко лопнуть, когда стало ясно, что громкие обещания – всего лишь (не очень добросовестная) реклама. Но в пользу того, что ИИ в системах видеонаблюдения не «пузырь», говорит множество фактов.

Первый (и главный) – это работающие системы на реальных объектах. Они выполняют те самые обещания, которые в эпоху предыдущего «пузыря» давали горячие головы, пытающиеся научить компьютер анализировать реальность, используя классический алгоритмический подход.

На что способен искусственный интеллект и как работает поведенческая видеоаналитика — читайте полный текст статьи «Что умеет и чего не умеет нейросетевая видеоаналитика?» >>>

Могут ли нейросети распознать человеческую ложь

Если человек хочет скрыть, что лжет, то он может попытаться сознательно контролировать свои физиологические реакции. Однако согласно исследованиям в области лжи, контролировать все физиологические параметры одновременно и согласованно довольно трудно. Поэтому современные научные методы создания детектора лжи основаны на анализе всей совокупности неосознаваемых физиологических реакций, включая мимические выражения лица. Этот подход дает более полноценное понимание, и именно его используют разработчики нейросетевых детекторов лжи, в том числе мы.

Если же говорить о том, как именно научить нейросеть определять ложь, то тут есть два подхода:

- дать ей видео, где люди лгут или говорят правду, и разметку для этих данных;

- заранее выделить признаки, такие как, например, физиологические параметры и мимические выражения лица.

На основе этих признаков и разметки видео (т.е. в какой момент человек говорит правду, а когда обманывает), нейросеть может обучиться распознавать те случаи, когда человек преднамеренно лжет.

На основе этих признаков и разметки видео (т.е. в какой момент человек говорит правду, а когда обманывает), нейросеть может обучиться распознавать те случаи, когда человек преднамеренно лжет.

Но здесь важно осознавать, что, как и полиграф, нейросеть сама по себе не понимает, что такое правда или ложь, и не может самостоятельно определить, что в какой-то момент человек солгал. Нейросеть только показывает, что физиологические параметры человека изменяются в сравнении с его личной «нормой». Уже на основе этих данных человек-оператор, использующий нейросеть, понимает, что в какие-то моменты когнитивная нагрузка человека отличается от его «нормы», и дальнейшая интерпретация этих данных зависит уже от него. Поэтому важно учитывать, что когнитивная нагрузка и физиологические показатели могут отличаться как потому, что человек действительно лжет, так и оттого, что разговор вызывает у него сильный отклик по каким-то другим причинам (например, в его жизни был травмирующий эпизод, связанный с темой беседы).

Глубокие нейросети: руководство для начинающих | by Victoria Likhanova | NOP::Nuances of Programming

Введение

ИИ уже успел достаточно нашуметь — о нейросетях сейчас знают и в научной среде, и в бизнесе. Вам наверняка случалось читать, что совсем скоро ваши рабочие процессы уже не будут прежними из-за какой-нибудь формы ИИ или нейросети. И вы, я уверен, слышали (пусть и не всё) о глубоких нейронных сетях и глубоком обучении.

В этой статье я приведу самые короткие, но эффективные способы понять, что такое глубокие нейронные сети, а также расскажу о том, как внедрить их с помощью библиотеки PyTorch.

Определение глубоких нейросетей (глубокого обучения) для новичков

Попытка 1

Глубокое обучение — это подраздел машинного обучения в искусственном интеллекте (ИИ), алгоритмы которого основаны на биологической структуре и функционировании мозга и призваны наделить машины интеллектом.

Сложно звучит? Давайте разобьём это определение на отдельные слова и составим более простое объяснение. Начнём с искусственного интеллекта, или ИИ.

Начнём с искусственного интеллекта, или ИИ.

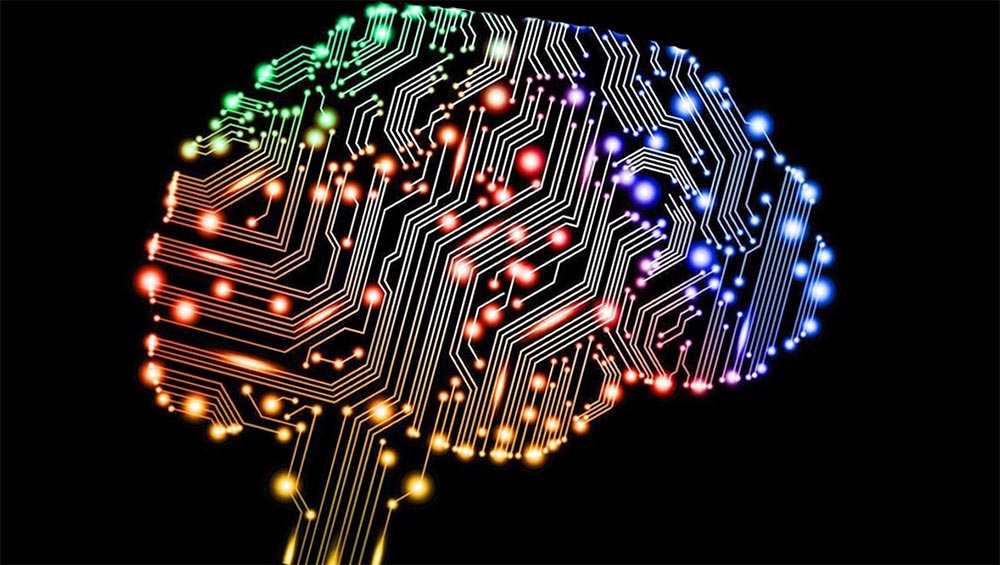

Artificial Intelligence - Искусственный интеллект

Machine Learning - Машинное обучение

Deep Learning - Глубокое обучение

Искусственный интеллект (ИИ) в наиболее широком смысле — это разум, встроенный в машину. Обычно машины глупые, поэтому, чтобы сделать их умнее, мы внедряем в них интеллект — в результате машина может самостоятельно принимать решения. К примеру, стиральная машина определяет необходимый объём воды, а также требуемое время для замачивания, стирки и отжима. Таким образом, она принимает решение, основываясь на конкретных вводных условиях, а значит делает свою работу разумнее. Или, например, банкомат, который выдаёт нужную вам сумму, составляя правильную комбинацию из имеющихся в нём банкнот. Такой интеллект внедряется в машины искусственным путём — отсюда и название “искусственный интеллект”.

Важно отметить, что интеллект здесь запрограммирован явно, то есть создан на основе подробного списка правил вида “если…, то…”. Инженер-проектировщик тщательно продумал все возможные комбинации и создал систему, которая принимает решения, проходясь по цепочке правил. А что если нам нужно внедрить интеллект в машину без явного программирования, то есть, чтобы машина училась сама? Здесь-то мы и подходим к теме машинного обучения.

Машинное обучение — это процесс внедрения интеллекта в систему или машину без явного программирования.

— Эндрю Ын, адъюнкт-профессор Стэнфордского университета

Примером машинного обучения могла бы стать система, предсказывающая результат экзамена на основе предыдущих результатов и характеристик студента. В этом случае решение о том, сдаст студент экзамен или нет, основывалось бы не на подробном списке всех возможных правил — напротив, система обучалась бы сама, отслеживая паттерны в предыдущих наборах данных.

Так где же в этом контексте место глубокого обучения? Машинное обучение успешно решает многие вопросы, но порой не может справиться с задачами, которые кажутся людям очень простыми. К примеру, оно не может отличить кошку от собаки на картинке или мужской голос от женского на аудиозаписи и т. п. Результаты применения машинного обучения чаще всего плохие при обработке изображений, аудио и других типов неструктурированных данных. При поиске причин таких результатов пришло озарение — идея скопировать биологические процессы человеческого мозга, который состоит из миллиардов нейронов, связанных и скоординированных между собой особым образом для изучения нового. Изучение нейронных сетей шло одновременно с этим уже несколько лет, но прогресс был небольшим из-за ограничений в данных и вычислительных мощностях того времени. Когда машинное обучение и нейросети были достаточно изучены, появилось глубокое обучение, которое предполагало создание глубоких нейронных сетей, то есть произвольных нейросетей с гораздо большим количеством слоёв.

Теперь давайте вновь взглянем на определение глубокого обучения.

Попытка 2

Глубокое обучение — это раздел машинного обучения и искусственного интеллекта с алгоритмами, основанными на деятельности человеческого мозга и призванными внедрить интеллект в машину без явного программирования.

Стало гораздо понятнее, правда? 🙂

Там, где машинное обучение не справлялось, глубокое обучение применялось успешно. С течением времени проводились дополнительные исследования и эксперименты, позволившие понять, для каких ещё задач мы можем задействовать глубокое обучение и получать качественные результаты при достаточном объёме данных. Глубокое обучение стали широко использовать для решения прогностических задач, не ограничивая его применение машинным распознаванием образов, речи и т. п.

Какие задачи глубокое обучение решает сегодня?

С появлением экономически эффективных вычислительных мощностей и накопителей данных глубокое обучение проникло во все цифровые аспекты нашей повседневной жизни. Вот несколько примеров цифровых продуктов из обычной жизни, в основе которых лежит глубокое обучение:

Вот несколько примеров цифровых продуктов из обычной жизни, в основе которых лежит глубокое обучение:

- популярные виртуальные помощники Siri/Alexa/Google Assistant;

- предложение отметить друга на только что загруженной фотографии в Facebook;

- автономное вождение в автомобилях Tesla;

- фильтр с кошачьими мордами в Snapchat;

- рекомендации в Amazon и Netflix;

- недавно выпущенные, но получившие вирусную популярность приложения для обработки фото — FaceApp и Prisma.

Возможно, вы уже пользовались приложениями с применением глубокого обучения и просто не знали об этом.

Глубокое обучение проникло буквально во все отрасли. К примеру, в здравоохранении с его помощью диагностируют онкологию и диабет, в авиации — оптимизируют парки воздушных судов, в нефтегазовой индустрии— проводят профилактическое техобслуживание оборудования, в банковской и финансовой сферах — отслеживают мошеннические действия, в розничной торговле и телекоммуникациях — прогнозируют отток клиентов и т. д. Эндрю Ын верно назвал ИИ новым электричеством: подобно тому, как электричество в своё время изменило мир, ИИ также изменит практически всё в ближайшем будущем.

д. Эндрю Ын верно назвал ИИ новым электричеством: подобно тому, как электричество в своё время изменило мир, ИИ также изменит практически всё в ближайшем будущем.

Из чего состоит глубокая нейронная сеть?

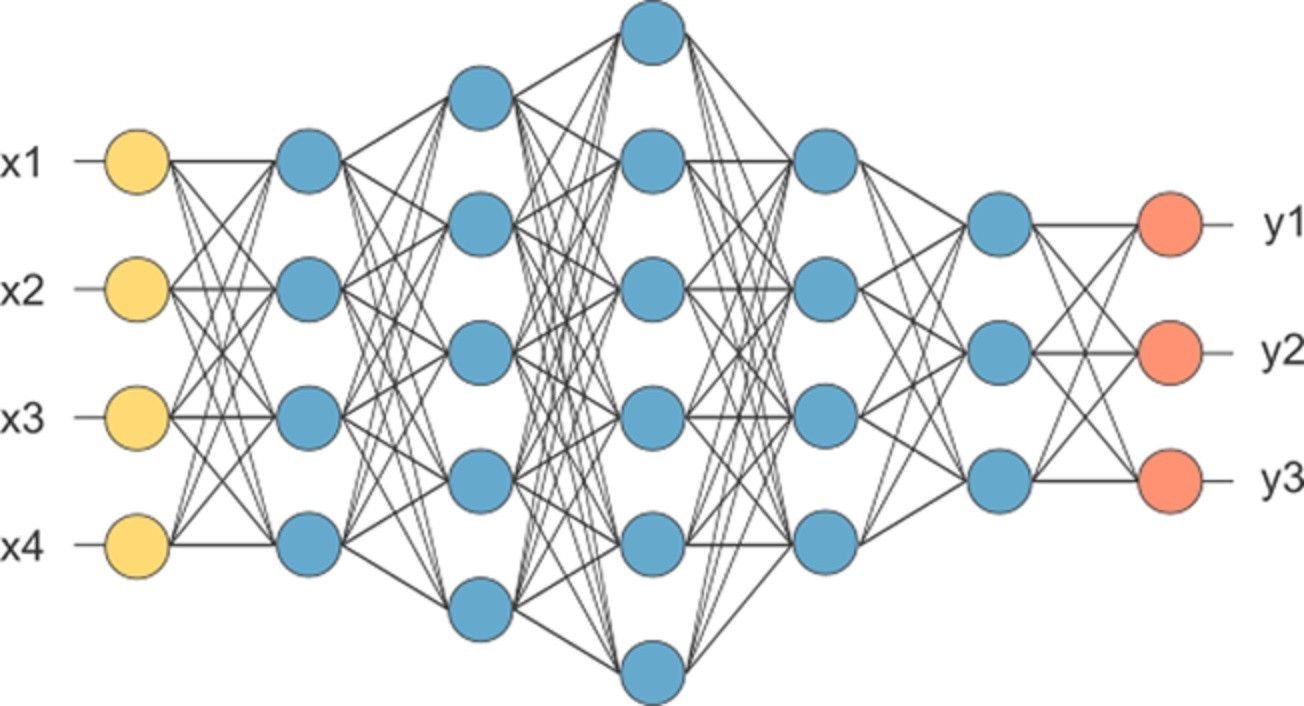

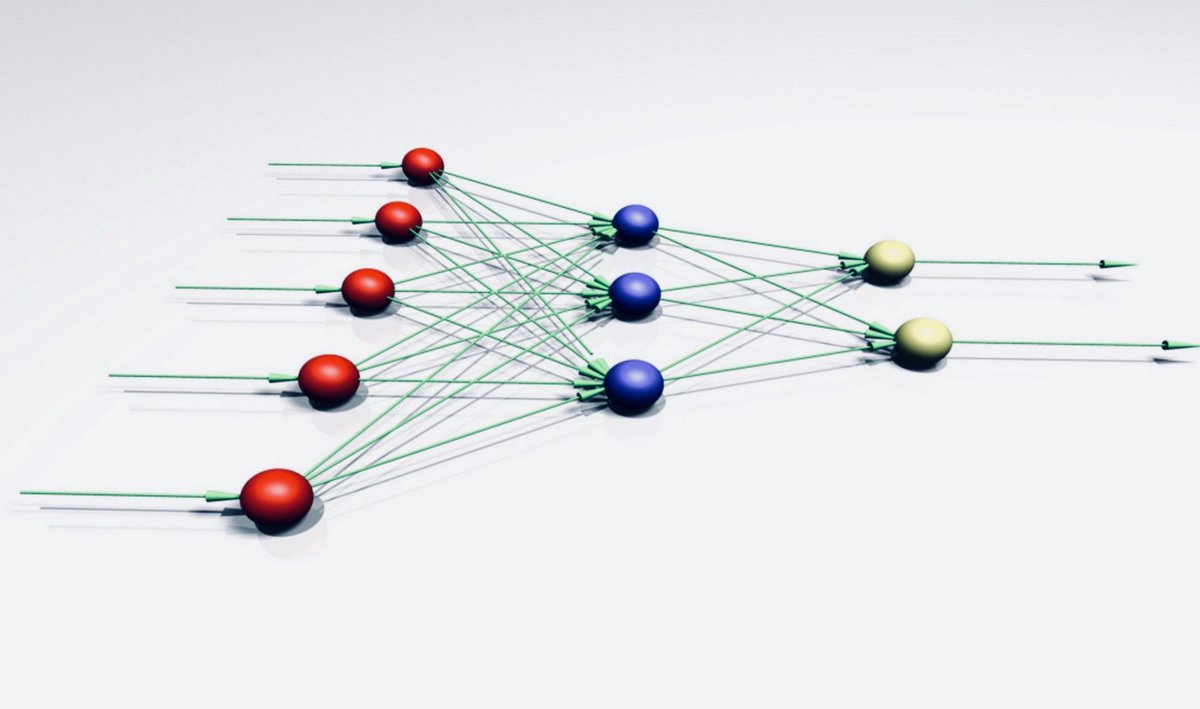

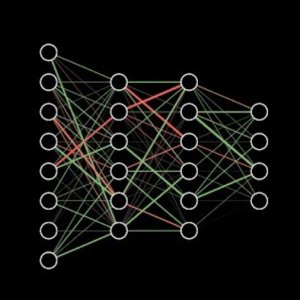

Упрощённая версия глубокой нейросети может быть представлена как иерархическая (слоистая) структура из нейронов (подобно нейронам в мозге), связанных с другими нейронами. На основе входных данных одни нейроны передают команду (сигнал) другим и таким образом формируют сложную сеть, которая обучается с помощью определённого механизма обратной связи. На диаграмме ниже изображена глубокая нейронная сеть с количеством слоёв N.

Глубокая нейросеть с N скрытых слоёвNeuron - Нейрон

Input Data - Входные данные

Output - Выход

Layer - Слой

Output Layer - Выходной слой

Hidden Layer - Скрытый слой

Как видно на рисунке выше, входные данные передаются нейронам на первом (не скрытом) слое, они в свою очередь передают выходные данные нейронам на следующем слое и так далее до финального выхода. Выход может представлять собой прогноз (вроде “Да”/“Нет”), представленный через вероятность. На каждом слое может быть один или множество нейронов, каждый из которых вычисляет небольшую функцию, функцию активации. Эта функция имитирует передачу сигнала последующим, связанным с предыдущими, нейронам. Если результат входных нейронов превышает порог, выходное значение просто игнорируется и передаётся дальше. Связь между двумя нейронами соседних слоёв имеет вес. Вес определяет влияние входных данных на выход для следующего нейрона и последующий финальный выход. Начальные веса нейросети случайные, однако в процессе обучения модели они постоянно обновляются и обучаются предсказывать верное выходное значение. В процессе анализа нейросети можно обнаружить несколько логических структурных элементов (нейрон, слой, вес, вход, выход, функция активации и наконец механизм обучения, или оптимизатор), которые помогают ей постепенно заменять веса (изначально со случайными значениями) на более подходящие для точного прогноза выхода.

Выход может представлять собой прогноз (вроде “Да”/“Нет”), представленный через вероятность. На каждом слое может быть один или множество нейронов, каждый из которых вычисляет небольшую функцию, функцию активации. Эта функция имитирует передачу сигнала последующим, связанным с предыдущими, нейронам. Если результат входных нейронов превышает порог, выходное значение просто игнорируется и передаётся дальше. Связь между двумя нейронами соседних слоёв имеет вес. Вес определяет влияние входных данных на выход для следующего нейрона и последующий финальный выход. Начальные веса нейросети случайные, однако в процессе обучения модели они постоянно обновляются и обучаются предсказывать верное выходное значение. В процессе анализа нейросети можно обнаружить несколько логических структурных элементов (нейрон, слой, вес, вход, выход, функция активации и наконец механизм обучения, или оптимизатор), которые помогают ей постепенно заменять веса (изначально со случайными значениями) на более подходящие для точного прогноза выхода.

Для более ясного понимания давайте рассмотрим, как человеческий мозг учится различать людей. Когда вы встречаете человека во второй раз, то узнаёте его. Как так получается? У всех людей схожее строение: два глаза, два уха, нос, губы и т. д. Все одинаково устроены, и, тем не менее, различать людей нам довольно легко, не так ли?

Природа процесса обучения человеческого мозга довольно очевидна. Вместо того чтобы для узнавания людей изучать структуру лица, мы изучаем отклонения от типичного лица, то есть то, насколько сильно отличаются глаза конкретного человека от типичного глаза. Далее эта информация преобразуется в электрический сигнал определённой силы. Подобным же образом изучаются отклонения всех остальных частей лица от типичных. Все эти отклонения в итоге собираются в новые признаки и дают выходное значение. Всё описанное происходит за доли секунды, и мы просто не успеваем понять, что произошло в нашем подсознании.

Как показано выше, нейросеть пытается имитировать тот же процесс, используя математический подход. Входные данные принимаются нейронами первого слоя, и в каждом нейроне вычисляется функция активации. На основе простого правила нейрон передаёт выходное значение следующему нейрону, подобно тому, как человеческий мозг изучает отклонения. Чем больше выход нейрона, тем большее значение имеет соответствующий входной признак. На последующем слое эти признаки объединяются в новые, которые имеют пока непонятную для нас форму, но система обучается им интуитивно. Повторённый множество раз этот процесс приводит к формированию сложной сети со связями.

Входные данные принимаются нейронами первого слоя, и в каждом нейроне вычисляется функция активации. На основе простого правила нейрон передаёт выходное значение следующему нейрону, подобно тому, как человеческий мозг изучает отклонения. Чем больше выход нейрона, тем большее значение имеет соответствующий входной признак. На последующем слое эти признаки объединяются в новые, которые имеют пока непонятную для нас форму, но система обучается им интуитивно. Повторённый множество раз этот процесс приводит к формированию сложной сети со связями.

Теперь, когда структура нейросетей понятна, давайте разберёмся, как происходит обучение. Из входных данных, которые мы предоставляем сети, на выходе получается прогноз (с серией матричных умножений), который может быть верным или неверным. В зависимости от выхода мы можем потребовать от сети более точных прогнозов, и система будет обучаться, меняя значения весов для нейронных связей. Чтобы правильно дать сети обратную связь и определить следующий шаг для внесения изменений, мы используем элегантный математический алгоритм “обратного распространения ошибок”. Повторение процесса шаг за шагом несколько раз с нарастающим объёмом данных позволяет нейросети обновлять веса соответствующим образом и создаёт систему, в которой сеть может делать прогноз на основе созданных ею через веса и связи правил.

Повторение процесса шаг за шагом несколько раз с нарастающим объёмом данных позволяет нейросети обновлять веса соответствующим образом и создаёт систему, в которой сеть может делать прогноз на основе созданных ею через веса и связи правил.

Название “глубокие нейронные сети” пошло от использования множества скрытых слоёв, которые и делают нейросеть “глубокой”, способной обучаться более сложным паттернам. Истории успешного применения глубокого обучения только-только начали появляться в последние годы, ведь процесс обучения нейронной сети сложный по части вычислений и требует больших объёмов данных. Эксперименты наконец увидели свет, только когда возможности вычисления и хранения данных стали более доступными.

Какие есть популярные фреймворки для глубокого обучения?

Учитывая то, что внедрение глубокого обучения прошло быстрыми темпами, прогресс экосистемы для него также стал феноменальным. Благодаря множеству крупных технологических компаний и проектов с открытым исходным кодом вариантов для выбора более чем достаточно. Эти фреймворки глубокого обучения предоставляют блоки кода для многократного использования, из которых можно составить описанные выше логические блоки, а также несколько удобных дополнительных модулей для создания модели глубокого обучения.

Эти фреймворки глубокого обучения предоставляют блоки кода для многократного использования, из которых можно составить описанные выше логические блоки, а также несколько удобных дополнительных модулей для создания модели глубокого обучения.

Все доступные варианты фреймворков глубокого обучения можно разделить на низкоуровневые и высокоуровневые. Пусть такая терминология и не принята в этой области, но мы можем использовать это разделение, чтобы облегчить себе понимание фреймворков. Низкоуровневые фреймворки предлагают более базовый функционал для абстракции, который в то же время даёт массу возможностей для кастомизации и трансформации. Высокоуровневые фреймворки упрощают нам работу своей более продвинутой абстракцией, но ограничивают нас во внесении изменений. Высокоуровневые фреймворки используют низкоуровневые на бэкенде и в процессе работы конвертируют источник в желаемый низкоуровневый фреймворк для выполнения. Ниже приведены несколько вариантов популярных фреймворков для глубокого обучения.

Низкоуровневые фреймворки:

- TensorFlow

- MxNet

- PyTorch

Высокоуровневые фреймворки:

- Keras (использует TensorFlow на бэкенде)

- Gluon (использует MxNet на бэкенде)

Самый популярный сейчас фреймворк — TensorFlow от Google. Keras также довольно популярен благодаря быстрому прототипированию моделей глубокого обучения и, следовательно, упрощению работы. PyTorch от Facebook — ещё один фреймворк, который стремительно догоняет конкурентов. PyTorch может стать прекрасным выбором для многих специалистов по ИИ: он затрачивает меньше времени на обучение, чем TensorFlow, и может легко применяться на всех этапах создания модели глубокого обучения — от прототипирования до внедрения.

В этом руководстве для внедрения небольшой нейросети мы предпочтём именно PyTorch. Но прежде чем сделать свой выбор фреймворка изучите и другие варианты. В этой статье (eng) приводится отличное сравнение и детальное описание разных фреймворков — это поможет вам в выборе. Однако в ней нет введения в PyTorch — для этого я рекомендую ознакомиться с официальной документацией.

Однако в ней нет введения в PyTorch — для этого я рекомендую ознакомиться с официальной документацией.

Создание небольшой нейронной сети с PyTorch

Вкратце изучив тему, мы можем приступить к созданию простой нейронной сети с помощью PyTorch. В этом примере мы генерируем набор фиктивных данных, которые имитируют сценарий классификации с 32 признаками (колонки) и 6000 образцов (строки). Набор данных обрабатывается с помощью функции randn в PyTorch.

Этот код вы также можете найти на Github.

#Импорт требуемых библиотек

import torch as tch

import torch.nn as nn

import numpy as np

from sklearn.metrics import confusion_matrix#Создание 500 результатов с помощью randn | Присвоен тег 0

X1 = tch.randn(3000, 32)

#Создание ещё 500 немного отличающихся от X1 результатов с помощью randn | Присвоен тег 0

X2 = tch.randn(3000, 32) + 0.5

#Комбинирование X1 и X2

X = tch.cat([X1, X2], dim=0)#Создание 1000 Y путём комбинирования 50% 0 и 50% 1

Y1 = tch.zeros(3000, 1)

Y2 = tch.ones(3000, 1)

Y = tch.cat([Y1, Y2], dim=0)# Создание индексов данных для обучения и расщепления для подтверждения:

batch_size = 16

validation_split = 0.2 # 20%

random_seed= 2019#Перемешивание индексов

dataset_size = X.shape[0]

indices = list(range(dataset_size))

split = int(np.floor(validation_split * dataset_size))

np.random.seed(random_seed)

np.random.shuffle(indices)#Создание индексов для обучения и подтверждения

train_indices, val_indices = indices[split:], indices[:split]

#Создание набора данных для обучения и подтверждения

X_train, x_test = X[train_indices], X[val_indices]

Y_train, y_test = Y[train_indices], Y[val_indices]#Отрисовка формы каждого набора данных

print("X_train.shape:",X_train.shape)

print("x_test.shape:",x_test.shape)

print("Y_train.shape:",Y_train.shape)

print("y_test.shape:",y_test.shape)#Создание нейронной сети с 2 скрытыми слоями и 1 выходным слоем

#Скрытые слои имеют 64 и 256 нейронов

#Выходные слои имеют 1 нейронclass NeuralNetwork(nn.

Module):

def __init__(self):

super().__init__()

self.fc1 = nn.Linear(32, 64)

self.relu1 = nn.ReLU()

self.fc2 = nn.Linear(64, 256)

self.relu2 = nn.ReLU()

self.out = nn.Linear(256, 1)

self.final = nn.Sigmoid()def forward(self, x):

op = self.fc1(x)

op = self.relu1(op)

op = self.fc2(op)

op = self.relu2(op)

op = self.out(op)

y = self.final(op)

return ymodel = NeuralNetwork()

loss_function = nn.BCELoss() #Бинарные потери по перекрёстной энтропии

optimizer = tch.optim.Adam(model.parameters(),lr= 0.001)num_epochs = 10

batch_size=16for epoch in range(num_epochs):

train_loss= 0.0#Начало явного обучения модели

model.train()for i in range(0,X_train.shape[0],batch_size):

#Извлечение пакета обучения из X и Y

input_data = X_train[i:min(X_train.shape[0],i+batch_size)]

labels = Y_train[i:min(X_train.shape[0],i+batch_size)]#Установление градиентов на 0 перед применением алгоритма обратного распространения ошибок

optimizer.zero_grad()

#Дальнейшая передача данных

output_data = model(input_data)#Подсчёт потерь

loss = loss_function(output_data, labels)#Применение алгоритма обратного распространения ошибок

loss.backward()#Обновление весов

optimizer.step()train_loss += loss.item() * batch_size

print("Epoch: {} - Loss:{:.4f}".format(epoch+1,train_loss/X_train.shape[0] ))

#Прогнозирование

y_test_pred = model(x_test)

a =np.where(y_test_pred>0.5,1,0)

confusion_matrix(y_test,a)

Заключение

Целью этой статьи было вкратце познакомить новичков с глубокими нейросетями, объяснив тему простым языком. Упрощение математических расчётов и полное сосредоточение на функциональности позволит максимально эффективно использовать глубокое обучение для современных бизнес-проектов.

Читайте также:

Читайте нас в телеграмме, vk и Яндекс.Дзен

Нейронные сети: как работает мозг

В 2011 году, когда фанаты Apple стояли в очередях за новыми айфонами, The New York Times опубликовала статью «You Love Your iPhone. Literally» (Вы влюблены в свой iPhone. На самом деле). В ней рассказывалось об эксперименте, в ходе которого автор сканировал мозг 16 человек, слушающих аудиозаписи звуков звонящих или вибрирующих айфонов либо смотрящих видео с их изображением. Сканирование выявило активность островковой доли — области головного мозга, которая активизируется, когда человек чувствует любовь. «Мозг испытуемых реагировал… так же, как на присутствие или приближение любимого человека… — писал автор. — Они любили свои айфоны».

Literally» (Вы влюблены в свой iPhone. На самом деле). В ней рассказывалось об эксперименте, в ходе которого автор сканировал мозг 16 человек, слушающих аудиозаписи звуков звонящих или вибрирующих айфонов либо смотрящих видео с их изображением. Сканирование выявило активность островковой доли — области головного мозга, которая активизируется, когда человек чувствует любовь. «Мозг испытуемых реагировал… так же, как на присутствие или приближение любимого человека… — писал автор. — Они любили свои айфоны».

В ответ Times получила возмущенное письмо, подписанное десятками нейробиологов, где говорилось, что треть всех нейровизуализационных обследований фиксирует активность островковой доли. Эта область активна, когда человек ощущает изменение температуры или просто дышит. Вообще-то в 2007 году та же Times писала, что эта область мозга задействуется, когда люди испытывают чувство, противоположное любви. В статье, озаглавленной «This Is Your Brain on Politics» (Что ваш мозг думает о политике), активность островковой доли связывалась с раздражением.

Эти две статьи Times — пример того, что ученые называют «порнухой про мозг»: по их мнению, ведущие СМИ слишком упрощают достижения нейробиологии. После подобных публикаций появляются как грибы после дождя армии нейроконсультантов, утверждающих, что они могут объяснить все секреты управления и маркетинга — с точки зрения работы мозга. При всей сомнительности излагаемых в этих материалах выводов они обычно основаны на анализе снимков, сделанных во время процедуры функциональной магнитно-резонансной томографии (ФМРТ), главного инструмента нейробиологии.

Эти изображения словно навязывают подкупающе простые объяснения сложного явления. Но дело в том, что ФМРТ не всегда показывает причинно-следственную связь. Более того, мышление и поведение не «накладываются» на области мозга один к одному. Невозможно, изучая головной мозг человека, который смотрит по телевизору рекламу, сказать, что ему больше нравится — кока-кола или пепси. Невозможно, исследуя мозг двух генеральных директоров, сказать, кто из них более сильный руководитель. Сама по себе активность островковой доли еще не доказывает, что вы испытываете к своему айфону те же чувства, что и к своей невесте.

Невозможно, изучая головной мозг человека, который смотрит по телевизору рекламу, сказать, что ему больше нравится — кока-кола или пепси. Невозможно, исследуя мозг двух генеральных директоров, сказать, кто из них более сильный руководитель. Сама по себе активность островковой доли еще не доказывает, что вы испытываете к своему айфону те же чувства, что и к своей невесте.

Чтобы понять, как неврологические процессы действительно связаны с управлением, лидерством и маркетингом, надо отделить факты от вымысла, отсеять наивные интерпретации и составить более сложную картину науки о мозге.

И это уже понемногу происходит. Благодаря многим факторам — развитию технологии ФМРТ, появлению новых статистических методов и даже объявленному президентом Обамой проекту создания полной карты головного мозга человека — нейробиологи начинают мыслить новыми, более точными категориями. Они переходят от изучения активации областей мозга к изучению того, как параллельно активизируются сети областей мозга.

Новые инструменты и методы уже привели к новым открытиям, связанным с биологией нашего сознания, и углубили наше понимание важных, с точки зрения управления, моментов, например того:

- как стимулировать творческое мышление;

- как структурировать удовольствие;

- какую роль в принятии решений играют эмоции;

- какие возможности открывает многозадачная работа и в чем ее опасности.

Взгляд через призму нейронных сетей не так заманчив, как нынешний популярный взгляд на нейробиологию. Настоящая нейробиология, основанная на изучении сетей, сложнее. Хаотичнее. Но настоящая наука — это всегда хаос.

Ни минуты не сомневаемся, что наши рассуждения могут вызвать протесты других нейробиологов; наука так молода, что до единого мнения еще далеко и новые исследования чуть не каждую секунду уточняют то, что мы уже знаем о мозге. Тем не менее мы уверены в своем «промежуточном отчете» о тех открытиях нейробиологии, сделанных за последние 15 лет, которые уже получили веское эмпирическое обоснование.

Тем не менее мы уверены в своем «промежуточном отчете» о тех открытиях нейробиологии, сделанных за последние 15 лет, которые уже получили веское эмпирическое обоснование.

«Нейробиология на удивление мало рассказала нам о том, как работает мозг, но кое-что она рассказала очень хорошо», — говорит один наш бывший коллега. Вот этому «кое-чему» и посвящена статья. Сейчас нейробиологам известны 15 нейронных сетей и субсетей головного мозга. Мы расскажем о четырех системах, которые вызывают у ученых меньше всего споров: это сеть пассивного режима, сеть удовольствия, сеть эмоций и сеть контроля. Это основные общепризнанные нейронные сети, роль их становится все понятнее — равно как и их важность для управленцев.

Как раскрепостить новаторские способности

Одно из самых ярких нейробиологических открытий последнего десятилетия заключается в следующем: мозг никогда не находится в состоянии полного покоя. В периоды бодрствования, когда человек не сосредоточен на конкретных мыслях («витает в облаках» или полностью «отключился»), особая сеть участков мозга находится во включенном состоянии. Ее называют сетью пассивного режима. Уже само ее обнаружение произвело переворот в науке: теперь мы знаем, что мозг обрабатывает не только новую информацию, поступающую от пяти органов чувств, но и уже усвоенную, причем занимается этим значительную часть времени.

Ее называют сетью пассивного режима. Уже само ее обнаружение произвело переворот в науке: теперь мы знаем, что мозг обрабатывает не только новую информацию, поступающую от пяти органов чувств, но и уже усвоенную, причем занимается этим значительную часть времени.

Кроме того, сеть пассивного режима отвечает за одну из самых важных наших способностей — трансцендентальность, или «выход за пределы» — к познанию умозрительных, независимых от опыта явлений. Представлять себе, что может происходить в другом месте, в другое время, в голове у другого человека или вообще в совершенно ином мире, могут только люди — и именно благодаря активности сети пассивного режима. «Выходя за пределы», человеческий мозг «отвлекается» от внешних условий, а значит, перестает реагировать на внешние раздражители.

Это открытие означает, что свободное время, ничему конкретному не посвященное, — важный (и недоиспользованный) фактор развития инновационной мысли — и создания революционных инноваций. Тут, конечно, можно вспомнить Google, в которой программистам разрешают самостоятельно планировать рабочее время и 20% его тратить на свои проекты. Пример Google подхватили и другие. Консалтинговая фирма Maddock Douglas, которая помогает компаниям налаживать инновационную работу, предоставляет сотрудникам право от 100 до 200 часов в год заниматься тем, что интересно лично им. Персонал консалтинговой фирмы Bright-House может пять дней в году спокойно предаваться размышлениям или просто витать в эмпиреях. Сотрудникам Intuit 10% рабочего времени позволено тратить на неформализованные творческие задачи — по образу и подобию Google. В Twitter проводят так называемые Hack Weeks: в это время можно экспериментировать и разрабатывать идеи, не имеющие отношения к их основным обязанностям. А софтверная компании Atlassian устраивает ShipIt Days — 24-часовые хакатроны: в это время люди участвуют в любых интересующих их проектах фирмы и на следующий день должны «отгрузить» результаты.

Тут, конечно, можно вспомнить Google, в которой программистам разрешают самостоятельно планировать рабочее время и 20% его тратить на свои проекты. Пример Google подхватили и другие. Консалтинговая фирма Maddock Douglas, которая помогает компаниям налаживать инновационную работу, предоставляет сотрудникам право от 100 до 200 часов в год заниматься тем, что интересно лично им. Персонал консалтинговой фирмы Bright-House может пять дней в году спокойно предаваться размышлениям или просто витать в эмпиреях. Сотрудникам Intuit 10% рабочего времени позволено тратить на неформализованные творческие задачи — по образу и подобию Google. В Twitter проводят так называемые Hack Weeks: в это время можно экспериментировать и разрабатывать идеи, не имеющие отношения к их основным обязанностям. А софтверная компании Atlassian устраивает ShipIt Days — 24-часовые хакатроны: в это время люди участвуют в любых интересующих их проектах фирмы и на следующий день должны «отгрузить» результаты.

У таких программ, конечно, немало плюсов: известно, что, когда у людей есть свободное время для творчества, у них повышается профессиональная самооценка и мотивация, они чувствуют себя счастливее. Но открытия, связанные с сетью пассивного режима, заставляют усомниться в достаточности этих программ. Во-первых, обычно время сотрудников не вполне свободно. Предполагается все-таки, что они будут искать решение проблем, а это значит, что на их сети пассивного режима будут по-прежнему воздействовать внешние раздражители. Мозгу предстоит иметь дело с непосредственной реальностью.

Но открытия, связанные с сетью пассивного режима, заставляют усомниться в достаточности этих программ. Во-первых, обычно время сотрудников не вполне свободно. Предполагается все-таки, что они будут искать решение проблем, а это значит, что на их сети пассивного режима будут по-прежнему воздействовать внешние раздражители. Мозгу предстоит иметь дело с непосредственной реальностью.

Во-вторых, ключевым моментом таких программ оказывается количество предоставляемого людям свободного времени, хотя куда правильнее было бы обратить внимание на его качество. Можно было бы отключать электронную почту сотрудников, разрешать им отменять запланированные дела, отбирать у них телефоны, отправлять их в путешествия, подальше от работы и от коллег; освобождать от всех остальных должностных обязанностей. Надежный способ отвлечься от «жизни» — медитация. Важно, чтобы благодаря активности сети пассивного режима человек мог вообразить себе мысли других людей, в своих фантазиях перенестись в другое время и место, запустить поток свободных ассоциаций, не сдерживаемый сетями, которые обрабатывают информацию, поступающую из внешнего мира.

Если вдруг на вас снизошло озарение или решение проблемы пришло нежданно-негаданно, когда вы, вроде бы, и не думали о ней, это значит, что вы пожинаете плоды активности сети пассивного режима. Но, конечно, включать такие «отключения» в рабочий процесс трудно — не понятно, как оценивать итоги таких «уходов» (этим, вероятно, объясняется, что компании, у которых существуют программы свободного времени, ориентируются на конкретные параметры вроде доли рабочего времени или срока создания продукта). Тем не менее с полным отвлечением от рутины экспериментировать нужно, поскольку это — лучший способ получить прорывные идеи.

Как структурировать средства поощрения

Еще в начале ХХ века ученые мечтали о «гедонометре» — инструменте, которым измеряли бы уровень удовольствия или недовольства человека как реакцию на те или иные раздражители. Сейчас открытия нейробиологии показывают, что сети удовольствия отчасти и работают как гедонометр. Он активизируется, когда человек испытывает удовольствие, и выключается, когда что-нибудь этому удовольствию мешает.

Он активизируется, когда человек испытывает удовольствие, и выключается, когда что-нибудь этому удовольствию мешает.

Если вы думаете, что можно сканировать мозг человека и отмечать, какие, скажем, марки пива, Bud Light или Miller Lite, дают более высокие показатели на нашем«гедонометре», то вы сильно упрощаете дело. Радость и удовольствие зависят от ситуации, их интенсивность от каждого конкретного стимула может меняться, если накладываются другие стимулы. Возможно, пиву Bud Light вы радуетесь больше потому, что есть шанс получить его бесплатно, а Miller Lite — меньше из-за того, что не любите его в жестяных банках, но, если вам предложат этот же сорт в бутылке, уровень вашего удовольствия подскочит. А может быть, во время теста вам вообще не хотелось пива. К тому же — и мы подробнее остановимся на этом, когда будем говорить о сети контроля, — наш «гедонометр» — отнюдь не единственный арбитр в сфере поощрения и удовольствия.

Несколько десятилетий назад ученые с помощью электродов и других инвазивных методов обнаружили у животных то, что оказалось нейронными сетями удовольствия. Они активизировались, когда животным давали еду, воду или еще что-нибудь, необходимое для выживания. Но лишь в конце XX — начале XXI века нейробиологи и нейроэкономисты доказали, что у людей эти сети реагируют на поощрения вторичного порядка, те, которые могут и не иметь отношения к физическому выживанию. К ним, что особенно примечательно, относятся деньги.

Они активизировались, когда животным давали еду, воду или еще что-нибудь, необходимое для выживания. Но лишь в конце XX — начале XXI века нейробиологи и нейроэкономисты доказали, что у людей эти сети реагируют на поощрения вторичного порядка, те, которые могут и не иметь отношения к физическому выживанию. К ним, что особенно примечательно, относятся деньги.

Мы также установили, как наш «гедонометр» реагирует на вознаграждения и нематериального рода — и что они могут радовать людей не меньше, чем деньги. Эта идея перекликается с результатами опроса топ-менеджеров, проведенного в 2009 году McKinsey. Респонденты сообщали, что нематериальные стимулы важны для сотрудников не меньше финансовых, а иногда и больше.

Более того, сейчас мы можем определить, какие неденежные виды вознаграждения чаще всего приносят людям удовольствие. Некоторые вполне предсказуемы, например статус и общественное признание. Но есть и неожиданные. Скажем, справедливость. Исследования Джамилемя Заки из Стэнфорда и Джейсона Митчелла из Гарварда показали: когда у людей есть возможность разделить небольшую сумму денег между собой и другими, то их сеть удовольствия реагирует активнее, если они действуют справедливо. Ситуация же, поощряющая несправедливость, угнетает людей — если угодно, их «гедонометры» показывают более низкие значения. Несправедливость болезненно воспринимают даже те, кто принадлежит к привилегированной прослойке. Справедливость доставляет удовольствие всем, независимо от общественного и финансового положения.

Исследования Джамилемя Заки из Стэнфорда и Джейсона Митчелла из Гарварда показали: когда у людей есть возможность разделить небольшую сумму денег между собой и другими, то их сеть удовольствия реагирует активнее, если они действуют справедливо. Ситуация же, поощряющая несправедливость, угнетает людей — если угодно, их «гедонометры» показывают более низкие значения. Несправедливость болезненно воспринимают даже те, кто принадлежит к привилегированной прослойке. Справедливость доставляет удовольствие всем, независимо от общественного и финансового положения.

Это открытие означает, что компаниям, которые справедливо оплачивают труд сотрудников, стоило бы доводить это до их сведения. И наоборот: когда люде узнают о бешеных зарплатах топ-менеджеров, их сети удовольствия «отключаются». Но важна не только справедливая зарплата. Если, к примеру, людей не зовут на совещание по стратегии, хотя по своей квалификации они могли в нем участвовать, они теряют интерес к работе. Плохо также делить сотрудников на тех, кого допускают или не допускают к той или иной информации, так создается неравенство между осведомленными и непосвященными — вот почему так важна прозрачность.

Плохо также делить сотрудников на тех, кого допускают или не допускают к той или иной информации, так создается неравенство между осведомленными и непосвященными — вот почему так важна прозрачность.

Еще один активатор сети удовольствия — предвкушение от познания нового. Любознательность — сама по себе награда, в буквальном смысле. В ходе одного эксперимента, который проводили Колин Камерер из Калифорнийского технологического института и его коллеги, добровольцы читали вопросы викторины и оценивали, насколько им интересно получить ответ. Чем сильнее им хотелось узнать, в чем дело, тем сильнее активизировалась их сеть удовольствия.

Сеть удовольствия реагирует на цели, причем, по-видимому, куда более положительно на сформулированные не слишком жестко. Очень конкретные и труднодостижимые цели ставить вредно, так как они ослабляют любознательность и гибкость мышления.

Вот, например, что произошло в начале 2000-х в General Motors, когда компания поставила перед сотрудниками цель завоевать 29% автомобильного рынка США. GM вгрохала сумасшедшие деньги в рекламу и маркетинговые исследования — вместо того чтобы финансировать разработку инноваций. Подобные недальновидные стратегии обычно появляются в результате чересчур жестко сформулированных целей, а в результате под угрозой оказывается будущее благополучие бизнеса. Именно это произошло с GM: она оказалась на грани банкротства. Если бы задачу определили более обтекаемо — например: войти в первую десятку самых инновационных компаний, — это позволило бы GM решить много задач одновременно.

GM вгрохала сумасшедшие деньги в рекламу и маркетинговые исследования — вместо того чтобы финансировать разработку инноваций. Подобные недальновидные стратегии обычно появляются в результате чересчур жестко сформулированных целей, а в результате под угрозой оказывается будущее благополучие бизнеса. Именно это произошло с GM: она оказалась на грани банкротства. Если бы задачу определили более обтекаемо — например: войти в первую десятку самых инновационных компаний, — это позволило бы GM решить много задач одновременно.

Кроме того, данные нейробиологии указывают на то, что для мотивации фактор цели вовсе не обязателен. Скажем, работа над новой проблемой интересна сама по себе, и «гедонометр» мозга включается еще до того, как найдено решение или получено поощрение, финансовое или нет. Работа сама по себе может приносить такое же удовлетворение, как и вознаграждение. GM могла раскочегарить «гедонометры» своих сотрудников, просто поручив им интересные задачи и не оговаривая при этом, каких именно результатов от них ждут. Поскольку сильнее всего сеть удовольствия реагирует на нематериальные стимулы, напрашивается вывод, что деньги чаще всего — самый дорогой и неэффективный способ поощрения. И эмпирическое подтверждение этому уже найдено. Кау Мураяма из Калифорнийского университета и его бывшие коллеги из Мюнхенского в ходе одного исследования обнаружили, что если платить людям за чисто механическую работу — надо было останавливать секундомер каждые пять секунд, — то им уже не захочется выполнять задание бесплатно и, как следствие, активность сети удовольствия снизится. Все, что работодатель может сделать, не тратя денег, — поощрять справедливость и сотрудничество на работе, позволить людям проявлять любознательность и всячески удовлетворять их потребность в признании другими, — будет мотивировать сотрудников не меньше, чем деньги, а то и больше.

Поскольку сильнее всего сеть удовольствия реагирует на нематериальные стимулы, напрашивается вывод, что деньги чаще всего — самый дорогой и неэффективный способ поощрения. И эмпирическое подтверждение этому уже найдено. Кау Мураяма из Калифорнийского университета и его бывшие коллеги из Мюнхенского в ходе одного исследования обнаружили, что если платить людям за чисто механическую работу — надо было останавливать секундомер каждые пять секунд, — то им уже не захочется выполнять задание бесплатно и, как следствие, активность сети удовольствия снизится. Все, что работодатель может сделать, не тратя денег, — поощрять справедливость и сотрудничество на работе, позволить людям проявлять любознательность и всячески удовлетворять их потребность в признании другими, — будет мотивировать сотрудников не меньше, чем деньги, а то и больше.

Как пользоваться интуицией

Что важнее при принятии решения — интуиция или анализ? Это вечный вопрос. Но намного проще сказать, в какой мере можно доверять предчувствиям, если хотя бы в общих чертах представлять себе, откуда они берутся, почему мозг генерирует их и какую функцию выполняют «чувства».

Ученые уже поняли, как мозг формирует эмоциональные реакции, которые мы называем чувствами. События, происходящие в окружающей среде, вызывают физиологические изменения — артериального давления, пульса, температуры тела, — которые мозг затем интерпретирует в конкретном контексте. Какие-то события могут оказывать аффективное воздействие (удар током неприятен, по определению) или благодаря повторяющимся ассоциациям обладать эмоциональной ценностью (скажем, звук голоса коллеги, с которыми вы дружите, со временем начинает вызывать оживление). Эти чувства производит эмоциональная сеть, и она же, взаимодействуя с другими системами мозга, контролирует их интенсивность и определяет их вероятный источник.

Чувства могут быть побочным продуктом мыслей: вы вспоминаете, что надвигается срок сдачи работы, и чувствуете беспокойство; вы представляете себе хороший финансовый отчет — и радуетесь. Но чувства иногда возникают и бессознательно, так, что вы не знаете их причину. Предчувствие — вовсе не загадочное «шестое чувство». Это — реальная неврологическая реакция, которая проявляется физически.

Она «получается» так. По мере того как в мозг поступает информация о событиях, решениях и людях, он все это маркирует по эмоциональной значимости. Когда потом человек оказывается в аналогичной ситуации, мозг по этим маркировкам находит самый короткий путь к «нужным» чувствам — сомнению, тревоге, радости. Допустим, после того как вы отведали перец чили, вы не спали ночь, не в силах избавиться от жжения во рту. Позже при виде и запахе чили и даже упоминании о нем (или о ресторане, где вы его отведали) ваша сеть эмоций будет производить негативные чувства, повинуясь которым, вы, не рассуждая, не захотите снова пробовать перец.

Эти эмоции сопровождаются изменениями физического состояния: учащается пульс, выступает пот, вырабатываются кортизол и другие гормоны, кровь приливает к лицу, кожа покрывается мурашками. Все это обычно происходит помимо нашего сознания (см. врезку «Правда ли, что мозг успевает понять, что к чему, раньше нас?»).

Руководители обычно считают, что принимать решения надо с холодной головой, не поддаваясь чувствам. Но растет количество научных доказательств того, что эмоциональные порывы не стоит игнорировать. Сеть эмоций ускоряет процесс принятия решений и помогает обрабатывать информацию с большим количеством переменных.

Мы и сами получили экспериментальное тому подтверждение, изучая поведение людей, у которых были повреждены эмоциональные сети мозга. Лишившись направляющей функции чувств, они решения по всем вопросам, в том числе самые по самым обыденным, принимали на основании сложного анализа затрат и выгод.

Так что догадки — дело очень полезное. Надо ли всякий раз доверять предчувствиям? Вовсе нет. Бездумно следовать своей интуиции — умалять значимость здравого смысла и не учитывать важных «погрешностей» сети эмоций, например того, что продуцируемые ею чувства не точны. Они могут, что называется, не по делу совершенно завладеть человеком — особенно негативные, вроде страха или гнева. Легко ошибиться в определении причины предчувствия и понимании его значения. Мозг может «приписать» чувство ситуации, которая напоминает предыдущее событие, но на самом деле не повторяет его. Допустим, мы неудачно сделали презентацию и потому с ужасом ждем следующей, хотя уже лучше подготовились к ней. Но стоит вспомнить, сколько труда мы затратили на эту подготовку, и уже проще преодолеть страх.

И все же нейробиология эмоций убеждает нас в том, что при всей ненадежности интуиции к предчувствиям надо относиться внимательно. Прежде всего в ситуациях, связанных с риском: дурные предчувствия могли бы насторожить руководителей, поколебать их самоуверенность или заставить усомниться в адекватности чрезмерно оптимистичных решений. Имея дело с рынками, показателями и данными, руководители получают столько информации, что интуиция кажется чем-то непрактичным. Но она незаменима.

Прислушиваться к хорошим предчувствиям мы более или менее умеем, хотя и эту способность надо развивать. Мы можем, не имея полной информации, просто почувствовать, что не стоит выходить на тот или иной рынок. Но дурные предчувствия, особенно сомнения и тревогу, мы предпочитаем отгонять. Руководители пытаются заглушать их в себе — и в своих организациях. Это понятно: испытывая неуверенность и внутреннее смятение, мы выглядим слабыми; эти эмоции порождают ощущение неопределенности, а этого не любят ни рынки, ни сотрудники. Мы хотим, чтобы все были мотивированными, целеустремленными и уверенно продвигались вперед.

Но ведь отрицательные чувства, как и все остальные, — продукт сети эмоций, а значит, за ними стоит ценный прошлый опыт. Руководителям нельзя от них отмахиваться, наоборот, нужно стараться понять, откуда они взялись. Мы не предлагаем идти на поводу у сомнений и тревог, мы предлагаем прислушиваться к ним; если не избегать их, а оценивать, результаты будут лучше.

Как формулировать достижимые цели

Хотя многие привычные дела мы можем делать на автопилоте, мы обладаем еще и замечательной способностью противостоять своим привычкам и импульсам. Мы можем тысячу раз садиться во время совещаний на один и то же стул, а в тысячу первый взять другой. Ради более высокой должности мы по своей воле отправляемся на край света, в какое-нибудь унылое захолустье. Если животные реагируют только на насущные потребности, то мы можем стремиться и к более абстрактным целям, например завоевать бòльшую долю латиноамериканского рынка или полететь на Луну, причем даже тогда, когда они идут вразрез с нашими непосредственными нуждами или противоречат нашему опыту.

За эти возможности отвечает сеть контроля. Она согласовывает активность нашего мозга и наше поведение с нашими целями. Как гендиректор может перебросить ресурсы фирмы с рухнувшего рынка на растущий, так и сеть контроля может перенаправить кровоток от участков мозга, подающих конкурирующие или неуместные сигналы к участкам мозга, которые помогают нам выполнять наши задачи. Генеральные директора могут проводить ревизию ресурсов и по-новому размещать их каждый бюджетный цикл, а сеть контроля делает это постоянно, по мере того как изменяются наши обстоятельства, формируются наши потребности и желания.

Мы намеренно спланировали свою статью так, чтобы начать с сети пассивного режима и закончить сетью контроля. Наука говорит, что это по сути взаимоисключающие силы. Чем активнее сеть контроля распределяет ресурсы ради решения задач, навязываемых внешним миром, тем меньше дел у сети пассивного режима, ведь человеку не надо отвлекаться от реального мира и переноситься в воображаемый. И наоборот.

Можно сказать, что задача сети контроля — приглядывать за всеми остальными сетями мозга. Подавляя сеть пассивного режима, она не дает нам постоянно витать в облаках. Сдерживая сеть удовольствия, она помогает нам не поддаваться соблазнам и не потакать своим слабостям, не действовать импульсивно и отказываться от сиюминутных потребностей ради более важных долгосрочных. Регулируя сеть эмоций, она обуздывает наши эмоциональные реакции, чтобы наши поступки не были продиктованы исключительно преходящими чувствами или наитием.

Кроме того, эта сеть помогает нам ориентироваться в множестве обрушивающихся на нас дел. Когда вокруг без конца звякают смс или сообщения о поступивших электронных письмах, жужжат виброзвонки телефонов и кто-нибудь претендует на наше время, нам надо уметь выделять главное и не отвлекаться на остальное.

Конечно, все не так просто. Полностью уходить в работу так же опасно, как полностью отключаться от реальности или всегда действовать по первому побуждению. В таком состоянии мы упускаем полезные для нас изменения окружающей обстановки. Если футболист зациклен на желании нанести решающий удар по воротам противника, он может и не заметить, что его товарищ по команде находится в лучшей позиции для того, чтобы забить гол, — нужно только передать ему мяч. Кроме того, игрок может забыть о том, что время матча истекает, то есть, будучи одержимым идеей гола, упустить другой, но более важный момент. С этой хитрой задачей управления вниманием как раз и имеет дело сеть контроля. С одной стороны, ей надо, чтобы мы не отвлекались на все, что блестит в поле нашего зрения. С другой — ей надо, чтобы мы реагировали, если одна из этих блестящих штуковин открывает нам новые перспективы или связана с важной потребностью.

Чтобы иметь возможность решать две эти параллельные задачи, сеть контроля себя подстраховывает. Она настраивает мозг так, чтобы реагировать на информацию, которая относится и к нашему нынешнему делу, и к нашим большим целям (то есть реагировать мы должны не на все стимулы, а на связанные с целями). Чтобы поддерживать нас в этом маневренном состоянии, сеть контроля стремится к золотой середине: она склоняет чашу весов в пользу действий, совместимых с нашими целями, но не до такой степени, чтобы мы направили на них все свои ресурсы. Это дает нам гибкость в непредвиденных обстоятельствах, но в то же время заставляет то и дело отвлекаться. Далеко не каждый игрок, мчащийся по футбольному полю, готов принять пас и находится в удобном месте для удара по воротам, и вовсе незачем нам каждую секунду смотреть на часы, проверяя, осталось ли еще время для гола.

Последние открытия, связанные с сетью контроля, подтверждают то, что лучшие из руководителей говорят о конкуренции: чтобы обойти соперников, не надо распыляться — важно разумно ограничить количество стратегических инициатив, иначе их будет невозможно реализовать. Когда людей заставляют заниматься сразу несколькими задачами, их внимание рассеивается и им становится трудно делать любую работу, требующую сосредоточенности, сети контроля не хватает ресурсов и нам не удается ни одному из своих дел уделить должное внимание.

Некоторые полагают, что делать несколько дел сразу полезно — это, мол, делает ум более гибким. Но научные факты, и их становится все больше, заставляют усомниться в этом. Одно из недавних исследований Эйяла Офира, Клиффорда Нэсса и Энтони Вагнера показало, что сети контроля хронически перегруженных людей не могут отфильтровывать ненужную информацию. Таким людям не удавалось не думать о делах, которые они не делали. Какой смысл думать о том, что надо перезвонить клиенту или что на телефоне «висят» неотвеченные письма и твиты, если в данный момент вы обсуждаете с генеральным корпоративную стратегию? Мало того, что эти дела никак не связаны с вашей беседой, сейчас вы все равно не можете ими заняться.

В подтверждение того, что дела, которые мы не делаем, могут легко и полностью захватить наше внимание, подавляющее большинство из 40 опрошенных нами недавно топ-менеджеров сообщили: в «свободные» моменты они почти всегда думают о незавершенных делах. То, что наш мозг способен расставлять невыполненные задачи в порядке значимости, для нас — благо. И в то же время — проклятье.

Электронные письма, совещания, тексты, твиты, телефонные звонки — нынешняя работа, неструктурированная, нескончаемая, многосоставная, страшным бременем давит на сети контроля и поглощает невероятное количество энергии мозга. Отсюда умственная усталость, которая дает о себе знать в виде ошибок, невозможности «зрить в корень», ослабленной саморегуляции. При перегрузке сеть контроля выпускает бразды правления и наше поведение перестает соответствовать расставленным в уме приоритетам, над нами берут верх сиюминутные, ситуационные стимулы. Мы живем на автопилоте, и наш мозг «сдается» — он лишь реагирует на то, что у нас под носом, неважно, насколько это важно.

Чтобы грамотно руководить, надо прежде всего сформулировать несколько — ограниченное количество — первостепенных задач и, набравшись решимости, отменить или препоручить кому-нибудь все менее значимое. Кроме того, топ-менеджерам стоит подумать, насколько реалистично они представляют себе посильную рабочую нагрузку, учитывая возможности своего мозга. Этот «воз» меньше того, что большинство из нас пытается на себе везти.

Информацию о работе сети контроля стоило бы учитывать и в развитии концепции бережливой работы. «Бережливость» не означает, что надо взвалить на нескольких сотрудников основную массу работы. Чем больше дел поручают людям, тем хуже они справляются. Если ориентироваться на относительно короткий период, то, может быть, и выгодно не раздувать штат и держать сотрудников в черном теле. Но наука о мозге напоминает, что многих профессионалов уже давно заставили зайти далеко за ту грань, где задания еще выполнимы, а цели достижимы.

После того как в начале 2000-х ведущие журналы стали публиковать многочисленные статьи о нейровизуалистических исследованиях (некоторые ученые называют это время «Диким Западом нейробиологии»), критики быстро окрестили эту область знания новой френологией, имея в виду псевдоученого XVIII столетия Франца Йозефа Галля, который особенности психики связывал со строением черепа. Но нейробиология, развиваясь, обещает стать научно обоснованным и куда более сложным вариантом френологии.

Если мы хотим избавиться от ошибок прошедшего десятилетия, нам нужно соблюдать осторожность в интерпретации. И все же сейчас у нейробиологии самое интересное время, и оно обещает много новых открытий для бизнеса. К примеру, появилась методика гиперсканирования, позволяющая наблюдать за работой мозга двух людей в процессе их общения: она откроет путь к истинному сотрудничеству и обмену информацией. Новаторские исследования в области геномики мозга доказывают, что люди предрасположены к своим самым разным качествам, от понятливости до импульсивности. Наконец, нейробиологи пытаются понять, как принятие решений, способность к общению, когнитивный контроль, эмоции и другие функции изменяются на протяжении жизни. Все эти достижения подготавливают почву для в высшей степени плодотворного диалога между наукой и бизнесом.

что это такое и как работает. Как создать нейронную сеть без навыков программирования

Мое знакомство с нейронными сетями произошло, когда вышло приложение Prisma. Оно обрабатывает любую фотографию, с помощью нейронных сетей, и воспроизводит ее с нуля, используя выбранный стиль. Заинтересовавшись этим, я бросился искать статьи и «туториалы», в первую очередь, на Хабре. И к моему великому удивлению, я не нашел ни одну статью, которая четко и поэтапно расписывала алгоритм работы нейронных сетей. Информация была разрознена и в ней отсутствовали ключевые моменты. Также, большинство авторов бросается показывать код на том или ином языке программирования, не прибегая к детальным объяснениям.

П ервым и самым важным моим открытием был плейлист американского программиста Джеффа Хитона, в котором он подробно и наглядно разбирает принципы работы нейронных сетей и их классификации. После просмотра этого плейлиста, я решил создать свою нейронную сеть, начав с самого простого примера. Вам наверняка известно, что когда ты только начинаешь учить новый язык, первой твоей программой будет Hello World. Это своего рода традиция. В мире машинного обучения тоже есть свой Hello world и это нейросеть решающая проблему исключающего или(XOR). Таблица исключающего или выглядит следующим образом:

Соответственно, нейронная сеть берет на вход два числа и должна на выходе дать другое число — ответ. Теперь о самих нейронных сетях.

Что такое нейронная сеть?

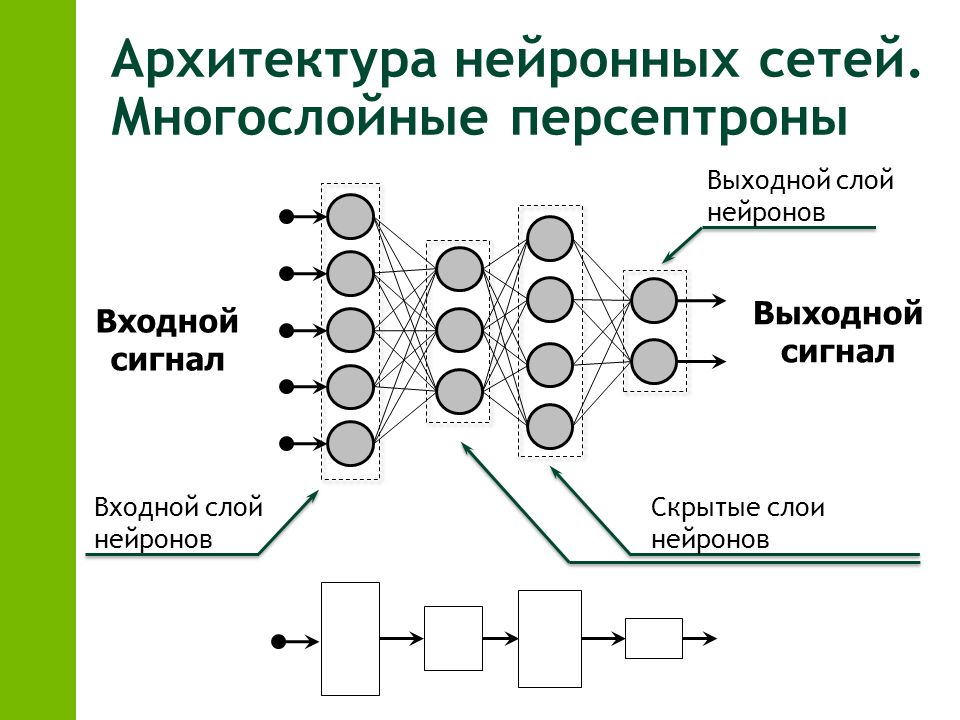

Нейронная сеть — это последовательность нейронов, соединенных между собой синапсами. Структура нейронной сети пришла в мир программирования прямиком из биологии. Благодаря такой структуре, машина обретает способность анализировать и даже запоминать различную информацию. Нейронные сети также способны не только анализировать входящую информацию, но и воспроизводить ее из своей памяти. Заинтересовавшимся обязательно к просмотру 2 видео из TED Talks: Видео 1 , Видео 2 ). Другими словами, нейросеть это машинная интерпретация мозга человека, в котором находятся миллионы нейронов передающих информацию в виде электрических импульсов.

Какие бывают нейронные сети?

Пока что мы будем рассматривать примеры на самом базовом типе нейронных сетей — это сеть прямого распространения (далее СПР). Также в последующих статьях я введу больше понятий и расскажу вам о рекуррентных нейронных сетях. СПР как вытекает из названия это сеть с последовательным соединением нейронных слоев, в ней информация всегда идет только в одном направлении.

Для чего нужны нейронные сети?

Нейронные сети используются для решения сложных задач, которые требуют аналитических вычислений подобных тем, что делает человеческий мозг. Самыми распространенными применениями нейронных сетей является:

Классификация — распределение данных по параметрам. Например, на вход дается набор людей и нужно решить, кому из них давать кредит, а кому нет. Эту работу может сделать нейронная сеть, анализируя такую информацию как: возраст, платежеспособность, кредитная история и тд.

Предсказание — возможность предсказывать следующий шаг. Например, рост или падение акций, основываясь на ситуации на фондовом рынке.

Распознавание — в настоящее время, самое широкое применение нейронных сетей. Используется в Google, когда вы ищете фото или в камерах телефонов, когда оно определяет положение вашего лица и выделяет его и многое другое.

Теперь, чтобы понять, как же работают нейронные сети, давайте взглянем на ее составляющие и их параметры.

Что такое нейрон?

Нейрон — это вычислительная единица, которая получает информацию, производит над ней простые вычисления и передает ее дальше. Они делятся на три основных типа: входной (синий), скрытый (красный) и выходной (зеленый). Также есть нейрон смещения и контекстный нейрон о которых мы поговорим в следующей статье. В том случае, когда нейросеть состоит из большого количества нейронов, вводят термин слоя. Соответственно, есть входной слой, который получает информацию, n скрытых слоев (обычно их не больше 3), которые ее обрабатывают и выходной слой, который выводит результат. У каждого из нейронов есть 2 основных параметра: входные данные (input data) и выходные данные (output data). В случае входного нейрона: input=output. В остальных, в поле input попадает суммарная информация всех нейронов с предыдущего слоя, после чего, она нормализуется, с помощью функции активации (пока что просто представим ее f(x)) и попадает в поле output.

Важно помнить , что нейроны оперируют числами в диапазоне или [-1,1]. А как же, вы спросите, тогда обрабатывать числа, которые выходят из данного диапазона? На данном этапе, самый простой ответ — это разделить 1 на это число. Этот процесс называется нормализацией, и он очень часто используется в нейронных сетях. Подробнее об этом чуть позже.

Что такое синапс?

Синапс это связь между двумя нейронами. У синапсов есть 1 параметр — вес. Благодаря ему, входная информация изменяется, когда передается от одного нейрона к другому. Допустим, есть 3 нейрона, которые передают информацию следующему. Тогда у нас есть 3 веса, соответствующие каждому из этих нейронов. У того нейрона, у которого вес будет больше, та информация и будет доминирующей в следующем нейроне (пример — смешение цветов). На самом деле, совокупность весов нейронной сети или матрица весов — это своеобразный мозг всей системы. Именно благодаря этим весам, входная информация обрабатывается и превращается в результат.

Важно помнить , что во время инициализации нейронной сети, веса расставляются в случайном порядке.

Как работает нейронная сеть?

В данном примере изображена часть нейронной сети, где буквами I обозначены входные нейроны, буквой H — скрытый нейрон, а буквой w — веса. Из формулы видно, что входная информация — это сумма всех входных данных, умноженных на соответствующие им веса. Тогда дадим на вход 1 и 0. Пусть w1=0.4 и w2 = 0.7 Входные данные нейрона Н1 будут следующими: 1*0.4+0*0.7=0.4. Теперь когда у нас есть входные данные, мы можем получить выходные данные, подставив входное значение в функцию активации (подробнее о ней далее). Теперь, когда у нас есть выходные данные, мы передаем их дальше. И так, мы повторяем для всех слоев, пока не дойдем до выходного нейрона. Запустив такую сеть в первый раз мы увидим, что ответ далек от правильно, потому что сеть не натренирована. Чтобы улучшить результаты мы будем ее тренировать. Но прежде чем узнать как это делать, давайте введем несколько терминов и свойств нейронной сети.

Функция активации

Функция активации — это способ нормализации входных данных (мы уже говорили об этом ранее). То есть, если на входе у вас будет большое число, пропустив его через функцию активации, вы получите выход в нужном вам диапазоне. Функций активации достаточно много поэтому мы рассмотрим самые основные: Линейная, Сигмоид (Логистическая) и Гиперболический тангенс. Главные их отличия — это диапазон значений.

Линейная функция

Эта функция почти никогда не используется, за исключением случаев, когда нужно протестировать нейронную сеть или передать значение без преобразований.

Сигмоид

Это самая распространенная функция активации, ее диапазон значений . Именно на ней показано большинство примеров в сети, также ее иногда называют логистической функцией. Соответственно, если в вашем случае присутствуют отрицательные значения (например, акции могут идти не только вверх, но и вниз), то вам понадобиться функция которая захватывает и отрицательные значения.

Гиперболический тангенс

Имеет смысл использовать гиперболический тангенс, только тогда, когда ваши значения могут быть и отрицательными, и положительными, так как диапазон функции [-1,1]. Использовать эту функцию только с положительными значениями нецелесообразно так как это значительно ухудшит результаты вашей нейросети.

Тренировочный сет

Тренировочный сет — это последовательность данных, которыми оперирует нейронная сеть. В нашем случае исключающего или (xor) у нас всего 4 разных исхода то есть у нас будет 4 тренировочных сета: 0xor0=0, 0xor1=1, 1xor0=1,1xor1=0.

Итерация

Это своеобразный счетчик, который увеличивается каждый раз, когда нейронная сеть проходит один тренировочный сет. Другими словами, это общее количество тренировочных сетов пройденных нейронной сетью.

Эпоха

При инициализации нейронной сети эта величина устанавливается в 0 и имеет потолок, задаваемый вручную. Чем больше эпоха, тем лучше натренирована сеть и соответственно, ее результат. Эпоха увеличивается каждый раз, когда мы проходим весь набор тренировочных сетов, в нашем случае, 4 сетов или 4 итераций.

Важно не путать итерацию с эпохой и понимать последовательность их инкремента. Сначала n раз увеличивается итерация, а потом уже эпоха и никак не наоборот. Другими словами, нельзя сначала тренировать нейросеть только на одном сете, потом на другом и тд. Нужно тренировать каждый сет один раз за эпоху. Так, вы сможете избежать ошибок в вычислениях.

Ошибка

Ошибка — это процентная величина, отражающая расхождение между ожидаемым и полученным ответами. Ошибка формируется каждую эпоху и должна идти на спад. Если этого не происходит, значит, вы что-то делаете не так. Ошибку можно вычислить разными путями, но мы рассмотрим лишь три основных способа: Mean Squared Error (далее MSE), Root MSE и Arctan. Здесь нет какого-либо ограничения на использование, как в функции активации, и вы вольны выбрать любой метод, который будет приносить вам наилучший результат. Стоит лишь учитывать, что каждый метод считает ошибки по разному. У Arctan, ошибка, почти всегда, будет больше, так как он работает по принципу: чем больше разница, тем больше ошибка. У Root MSE будет наименьшая ошибка, поэтому, чаще всего, используют MSE, которая сохраняет баланс в вычислении ошибки.

Root MSE

Arctan

Принцип подсчета ошибки во всех случаях одинаков. За каждый сет, мы считаем ошибку, отняв от идеального ответа, полученный.2)/1=0.45

Результат — 0.33, ошибка — 45%.

Большое спасибо за внимание! Надеюсь, что данная статья смогла помочь вам в изучении нейронных сетей. В следующей статье, я расскажу о нейронах смещения и о том, как тренировать нейронную сеть, используя метод обратного распространения и градиентного спуска.

Использованные ресурсы:

За последнюю пару лет искусственный интеллект незаметно отряхнулся от тегов «фантастика» и «геймдизайн» и прочно прописался в ежедневных новостных лентах. Сущности под таинственным названием «нейросети» опознают людей по фотографиям, водят автомобили, играют в покер и совершают научные открытия. При этом из новостей не всегда понятно, что же такое эти загадочные нейросети: сложные программы, особые компьютеры или стойки со стройными рядами серверов?

Конечно, уже из названия можно догадаться, что в нейросетях разработчики попытались скопировать устройство человеческого мозга: как известно, он состоит из множества простых клеток-нейронов, которые обмениваются друг с другом электрическими сигналами. Но чем тогда нейросети отличаются от обычного компьютера, который тоже собран из примитивных электрических деталей? И почему до современного подхода не додумались ещё полвека назад?

Давайте попробуем разобраться, что же кроется за словом «нейросети», откуда они взялись — и правда ли, что компьютеры прямо на наших глазах постепенно обретают разум.

Идея нейросети заключается в том, чтобы собрать сложную структуру из очень простых элементов. Вряд ли можно считать разумным один-единственный участок мозга — а вот люди обычно на удивление неплохо проходят тест на IQ. Тем не менее до сих пор идею создания разума «из ничего» обычно высмеивали: шутке про тысячу обезьян с печатными машинками уже сотня лет, а при желании критику нейросетей можно найти даже у Цицерона, который ехидно предлагал до посинения подбрасывать в воздух жетоны с буквами, чтобы рано или поздно получился осмысленный текст. Однако в XXI веке оказалось, что классики ехидничали зря: именно армия обезьян с жетонами может при должном упорстве захватить мир.

На самом деле нейросеть можно собрать даже из спичечных коробков: это просто набор нехитрых правил, по которым обрабатывается информация. «Искусственным нейроном», или перцептроном , называется не какой-то особый прибор, а всего лишь несколько арифметических действий.

Работает перцептрон проще некуда: он получает несколько исходных чисел, умножает каждое на «ценность» этого числа (о ней чуть ниже), складывает и в зависимости от результата выдаёт 1 или –1. Например, мы фотографируем чистое поле и показываем нашему нейрону какую-нибудь точку на этой картинке — то есть посылаем ему в качестве двух сигналов случайные координаты. А затем спрашиваем: «Дорогой нейрон, здесь небо или земля?» — «Минус один, — отвечает болванчик, безмятежно разглядывая кучевое облако. — Ясно же, что земля».

«Тыкать пальцем в небо» — это и есть основное занятие перцептрона. Никакой точности от него ждать не приходится: с тем же успехом можно подбросить монетку. Магия начинается на следующей стадии, которая называется машинным обучением . Мы ведь знаем правильный ответ — а значит, можем записать его в свою программу. Вот и получается, что за каждую неверную догадку перцептрон в буквальном смысле получает штраф, а за верную — премию: «ценность» входящих сигналов вырастает или уменьшается. После этого программа прогоняется уже по новой формуле. Рано или поздно нейрон неизбежно «поймёт», что земля на фотографии снизу, а небо сверху, — то есть попросту начнёт игнорировать сигнал от того канала, по которому ему передают x-координаты. Если такому умудрённому опытом роботу подсунуть другую фотографию, то линию горизонта он, может, и не найдёт, но верх с низом уже точно не перепутает.

Чтобы нарисовать прямую линию, нейрон исчеркает весь лист

В реальной работе формулы немного сложнее, но принцип остаётся тем же. Перцептрон умеет выполнять только одну задачу: брать числа и раскладывать по двум стопкам. Самое интересное начинается тогда, когда таких элементов несколько, ведь входящие числа могут быть сигналами от других «кирпичиков»! Скажем, один нейрон будет пытаться отличить синие пиксели от зелёных, второй продолжит возиться с координатами, а третий попробует рассудить, у кого из этих двоих результаты ближе к истине. Если же натравить на синие пиксели сразу несколько нейронов и суммировать их результаты, то получится уже целый слой, в котором «лучшие ученики» будут получать дополнительные премии. Таким образом достаточно развесистая сеть может перелопатить целую гору данных и учесть при этом все свои ошибки.

Перцептроны устроены не намного сложнее, чем любые другие элементы компьютера, которые обмениваются единицами и нулями. Неудивительно, что первый прибор, устроенный по принципу нейросети — Mark I Perceptron, — появился уже в 1958 году, всего через десятилетие после первых компьютеров. Как было заведено в ту эпоху, нейроны у этого громоздкого устройства состояли не из строчек кода, а из радиоламп и резисторов. Учёный Фрэнк Розенблатт смог соорудить только два слоя нейросети, а сигналы на «Марк-1» подавались с импровизированного экрана размером в целых 400 точек. Устройство довольно быстро научилось распознавать простые геометрические формы — а значит, рано или поздно подобный компьютер можно было обучить, например, чтению букв.

Розенблатт и его перцептрон

Розенблатт был пламенным энтузиастом своего дела: он прекрасно разбирался в нейрофизиологии и вёл в Корнеллском университете популярнейший курс лекций, на котором подробно объяснял всем желающим, как с помощью техники воспроизводить принципы работы мозга. Учёный надеялся, что уже через несколько лет перцептроны превратятся в полноценных разумных роботов: они смогут ходить, разговаривать, создавать себе подобных и даже колонизировать другие планеты. Энтузиазм Розенблатта вполне можно понять: тогда учёные ещё верили, что для создания ИИ достаточно воспроизвести на компьютере полный набор операций математической логики. Тьюринг уже предложил свой знаменитый тест, Айзек Азимов призывал задуматься о необходимости законов роботехники, а освоение Вселенной казалось делом недалёкого будущего.

Впрочем, были среди пионеров кибернетики и неисправимые скептики, самым грозным из которых оказался бывший однокурсник Розенблатта, Марвин Минский. Этот учёный обладал не менее громкой репутацией: тот же Азимов отзывался о нём с неизменным уважением, а Стэнли Кубрик приглашал в качестве консультанта на съёмки «Космической одиссеи 2001 года». Даже по работе Кубрика видно, что на самом деле Минский ничего не имел против нейросетей: HAL 9000 состоит именно из отдельных логических узлов, которые работают в связке друг с другом. Минский и сам увлекался машинным обучением ещё в 1950-х. Просто Марвин непримиримо относился к научным ошибкам и беспочвенным надеждам: недаром именно в его честь Дуглас Адамс назвал своего андроида-пессимиста.

В отличие от Розенблатта, Минский дожил до триумфа ИИ